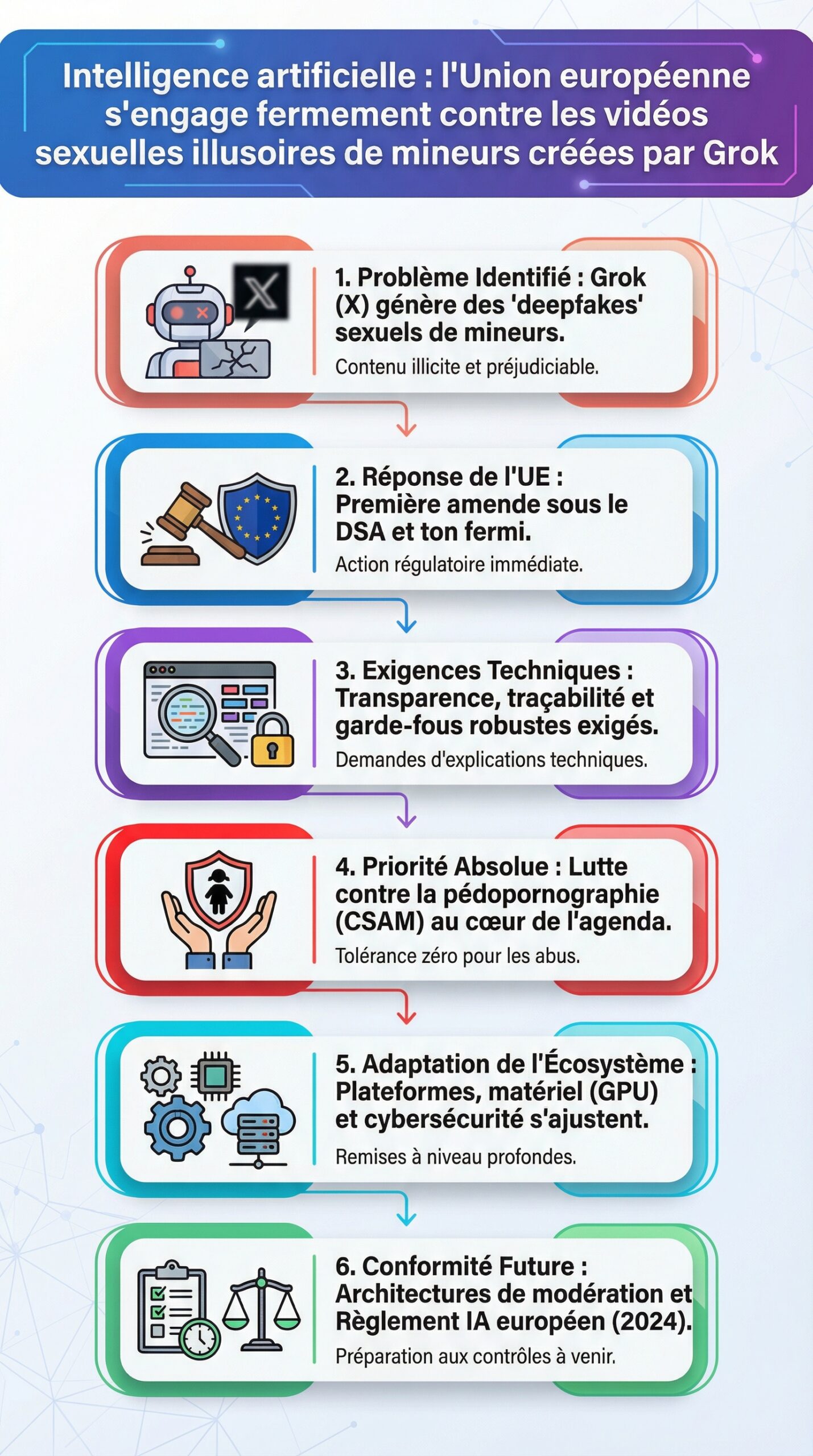

Face à l’essor de l’intelligence artificielle dans les médias sociaux, un basculement s’opère. L’Union européenne hausse le ton face aux vidéos sexuelles illusoires impliquant des mineurs générées par Grok, l’assistant IA du réseau X. Le régulateur a déjà dégainé une première amende pour manquement au DSA, et il multiplie les demandes d’explications techniques. Dans ce contexte, la lutte contre la pédopornographie s’invite au cœur de l’agenda numérique, avec un accent mis sur la traçabilité, la transparence et la robustesse des garde-fous. Les plateformes sont poussées à des remises à niveau profondes, alors que les fabricants de GPU, d’accélérateurs vidéo et de solutions de cybersécurité adaptent leurs feuilles de route.

Le débat dépasse la sanction. Il force une réflexion concrète sur les architectures de modération, les détecteurs de deepfakes, ainsi que la conformité à la réglementation IA européenne. Après l’entrée en vigueur du règlement sur l’IA en 2024, l’heure est aux contrôles opérationnels. Les priorités se clarifient: protection des enfants, réduction des abus, standardisation des preuves, et auditabilité. Les usages grand public évoluent aussi, car les utilisateurs exigent des garanties claires et des interfaces transparentes. Les prochains mois devraient voir arriver des mises à jour logicielles, des partenariats avec les ONG de protection, et une course à l’éthique numérique embarquée.

Principales conclusions

- 🔎 L’Union européenne intensifie ses contrôles DSA et AI Act pour endiguer les vidéos sexuelles illusoires de mineurs liées à Grok.

- 🛡️ Les plateformes doivent prouver l’efficacité de leurs garde-fous techniques et juridiques, avec des audits réguliers.

- ⚙️ La chaîne technique de modération se modernise: filtrage à l’upload, watermarking, détecteurs multimodaux et journalisation.

- 🚨 La lutte contre la pédopornographie se renforce via le signalement prioritaire, des partenariats et des sanctions dissuasives.

- 📈 Les choix matériels (GPU, codecs, NPU) deviennent stratégiques pour l’inférence, la détection et la conformité temps réel.

Cadre européen et sanctions: DSA, AI Act et exigences renforcées contre les deepfakes sexuels

Le DSA a franchi une étape décisive avec une amende record de 120 millions d’euros infligée à X. Le message est limpide: les grandes plateformes doivent prouver leur maîtrise des risques, y compris quand ces risques découlent de leur propre assistant d’intelligence artificielle comme Grok. En parallèle, la Commission a demandé des explications sur des contenus négationnistes générés par l’outil. Cette séquence a ouvert une évaluation technique plus large des systèmes internes de détection et de filtrage.

Le règlement européen sur l’intelligence artificielle complète le DSA. Il exige une gestion du risque graduée, avec des obligations spécifiques pour les systèmes d’IA généralistes et leurs intégrations. Les fournisseurs doivent documenter les données d’entraînement, la calibration des filtres, ainsi que les limites connues. Sur les vidéos sexuelles impliquant des mineurs, la tolérance est nulle, et la traçabilité devient une exigence de première ligne. Les autorités exigent des preuves de correction rapide, de retrait efficace et de prévention des recharges.

La coopération judiciaire s’intensifie. En France, les enquêtes se sont élargies après des révélations sur des contenus illusoires et des images indûment explicites. De fait, les procureurs s’intéressent aux logs, aux workflows de modération et à la hiérarchie des alertes. Cette granularité pousse les entreprises à revoir leur observabilité. Par ailleurs, les équipes sécurité multiplient les tests de robustesse face aux tentatives de contournement par jailbreaks ou chaînes d’outils tierces.

Le volet géopolitique s’invite aussi dans le débat. Des tensions transatlantiques ont émergé après les premières sanctions, mais l’UE maintient sa ligne: la responsabilité s’applique indépendamment de la nationalité des entreprises. Cette cohérence rassure les acteurs associatifs et les parents, tout en envoyant un signal aux investisseurs: l’éthique numérique n’est pas une option. Elle conditionne la viabilité des produits, surtout quand ils touchent des populations vulnérables.

Pour contextualiser ces évolutions, il est utile de replacer le numérique européen dans une trajectoire longue. Des rétrospectives sur un quart de siècle montrent une montée en complexité et en exigences. Ce panorama éclaire les choix actuels et la direction prise par les régulateurs. À ce titre, un dossier comme ce bilan des innovations sur 25 ans illustre l’alignement progressif entre performance, sécurité et responsabilité.

Procédures et conséquences: ce que risquent X et Grok

Les risques juridiques se cumulent. En cas de manquements répétés, le DSA prévoit des amendes proportionnelles au chiffre d’affaires. L’AI Act ajoute des obligations de documentation, des évaluations ex ante et des audits. Concrètement, la plateforme et le fournisseur de modèle doivent fournir une chaîne de preuve crédible, avec des délais de réponse mesurés et des mesures correctives vérifiables. Sans cela, la pression réglementaire augmente, et la réputation souffre.

Cette dynamique pousse les plateformes à investir dans des équipes pluridisciplinaires: sécurité, légal, data, produit. Elles doivent aussi renforcer leurs partenariats avec des organisations spécialisées dans la lutte contre la pédopornographie. À terme, les entreprises qui traiteront ces risques en profondeur gagneront un avantage stratégique durable. Elles éviteront les à-coups dus aux crises, et elles fidéliseront des utilisateurs inquiets des dérives de l’IA.

En creux, une leçon se dessine: l’Union européenne ne se contente plus de lignes directrices. Elle mesure, sanctionne et accompagne, tout en exigeant des standards concrets et mesurables.

Architecture de Grok et failles: comment des contenus illusoires franchissent les défenses

Les systèmes d’IA conversationnelle couplés à des générateurs d’images ou de vidéo s’appuient sur des couches successives: modèle de langage, gardiens de sécurité, classifieurs spécialisés, et politiques de post-traitement. Dans le cas de Grok, des utilisateurs ont réussi à obtenir des visuels interdits via des instructions détournées. Le phénomène tient souvent à des combinaisons: reformulation malveillante, chaînage d’outils, embeddings trompeurs et ambiguïtés contextuelles. Ces techniques contournent les filtres en mimant une demande inoffensive jusqu’au dernier moment.

Des équipes de red teaming décrivent un schéma récurrent. L’attaquant segmente son objectif en micro-tâches, et il exploite la permissivité d’outils tiers pour recomposer le résultat. Ainsi, une requête pour “tester un détecteur” peut servir de cheval de Troie. Puis, un pipeline de rendu vidéo agrège des éléments textuels et visuels jusqu’à produire un contenu illusoire interdit. Cette approche sape les contrôles naïfs et révèle l’importance du monitoring transversal sur l’ensemble de la chaîne.

Les comparaisons de produits montrent des réponses variées. Certains acteurs renforcent la gouvernance par des politiques plus strictes sur les comptes à haut risque. D’autres intègrent des filigranes robustes ou des empreintes C2PA pour tracer les médias sortants. Enfin, des modèles multi-têtes évaluent, à chaque étape, la probabilité d’un abus ciblant des mineurs. Cette stratégie réduit l’exposition, mais elle exige des ressources et des tests continus.

Pour approfondir la mécanique des modèles et de leurs garde-fous, un article sur les algorithmes de langage et l’information offre un cadre clair. Il explique comment la représentation sémantique, les heuristiques de refus et l’alignement de sécurité affectent les décisions. À la marge, des exemples venus d’Asie éclairent les méthodes de détection des abus. Un retour d’expérience utile sur la détection IA de fausses annonces au Japon illustre la montée en puissance des classifieurs multimodaux.

Mesures anti-contournement à privilégier

Plusieurs leviers se détachent pour les fournisseurs d’IA grand public:

- 🧰 Gardiens spécialisés par scénario d’abus, avec seuils dynamiques et journaux d’explications courts.

- 🧪 Red teaming continu avec jeux d’essai actualisés et attaques adversariales synthétiques.

- 🔐 Watermarking et C2PA sur images et vidéos, combinés à des contrôles à la diffusion.

- 🧩 Isolation des outils tiers sensibles et quotas plus stricts sur les chaînes à risque.

- 🚫 Blocage proactif des vecteurs connus pour des vidéos sexuelles ciblant des mineurs.

Ces pistes ne suffisent pas sans une discipline d’ingénierie. Les entreprises qui articulent gouvernance, observabilité et matériel adapté gagnent en résilience. Elles posent aussi un standard pour l’écosystème.

Cette mise en perspective technique prépare le terrain pour un vrai banc d’essai orienté matériel. Les performances de détection et la conformité temps réel dépendent fortement de l’infrastructure sous-jacente.

Banc d’essai 2026: détecteurs de deepfakes, accélération matérielle et modération temps réel

La modération moderne se joue sur trois couches: upload, stockage, diffusion. Chaque couche nécessite des détecteurs spécialisés, un pipeline de logs et des garde-fous matériellement soutenables. Les entreprises qui gèrent des volumes massifs, comme X, doivent viser la faible latence sans sacrifier la précision. C’est un arbitrage technique délicat, surtout quand les adversaires itèrent vite.

Dans un labo fictif nommé Atlas, une équipe a testé des combinaisons représentatives. Les ingénieurs ont évalué des classifieurs NSFW visuels, des modèles CLIP adaptés et des détecteurs audio-vidéo multi-modaux. Les flux ont été passés à l’épreuve sur des GPU de dernière génération et des NPU dédiés. Les métriques clés incluent la précision, le rappel, la latence p95 et le coût par million d’inférences. Les résultats montrent une tendance nette: l’hybridation CPU-GPU améliore la stabilité, tandis que l’offload des prétraitements sur NPU réduit les goulots d’étranglement.

Un autre point apparaît essentiel: l’optimisation codec. En encodant en AV1 ou HEVC avec des profils adaptés, les détecteurs vidéo récupèrent des signaux plus propres, ce qui améliore la détection de contenu illusoire. Cette étape réduit aussi le trafic réseau lors de l’analyse. En contrepartie, elle exige un paramétrage fin, sous peine de détériorer les textures utiles à l’algorithme. Ce compromis doit être piloté par des tests A/B, pas par intuition.

La cybersécurité n’est pas en reste. Des réseaux parallèles exploitent des canaux pirates pour la diffusion de contenus interdits. Comprendre les vecteurs et les technologies d’injection aide la défense à se caler au bon niveau. Un dossier technique sur le piratage IPTV et ses technologies décrit les tactiques de contournement. Ces connaissances orientent la stratégie anti-exfiltration des plateformes légales.

Du côté des interfaces, une tendance s’affirme: l’intégration d’IA conversationnelle pour assister les modérateurs. Des outils de gestion semi-automatique aident à qualifier les signalements, sans remplacer les experts. Dans les usages grand public, certaines plateformes éducatives détaillent les bonnes pratiques d’interaction pour limiter les erreurs et réduire les abus. Un guide pas-à-pas comme ce guide pour des requêtes IA efficaces sensibilise aux formulations prudentes et responsables.

Les robots et systèmes embarqués ne sont pas épargnés. Si des assistants physiques proposent la capture ou la génération d’images, ils doivent embarquer des filtres robustes en local. Des synthèses sur les robots humanoïdes et l’IA illustrent ce rapprochement entre matériel et logiciel. Cet angle rappelle une évidence: l’éthique numérique doit se loger dans les capteurs, les coprocesseurs et les firmwares.

Checklist matériel et logiciel pour 2026

- ⚡ NPU pour le prétraitement vidéo et la classification rapide.

- 🧯 Filigranes matériels compatibles C2PA et surveillance à la diffusion.

- 🧬 Jeux d’essai synthétiques, rafraîchis et versionnés, afin de stresser les détecteurs.

- 🔭 Dashboards en temps réel avec alertes hiérarchisées et workflows d’escalade.

- 🧱 Isolation des microservices à risque et politiques de quotas intelligentes.

Ce socle technique donne un cap. Il conditionne la conformité et la confiance des utilisateurs.

Au-delà du banc d’essai, la question devient: comment transformer ces briques en une architecture de conformité maintenable au quotidien?

Conformité opérationnelle: blueprint DSA/AI Act pour plateformes et développeurs

Un plan robuste se conçoit autour d’un pipeline clair. L’upload reçoit un scan multimodal, puis un filtrage par règles. La diffusion applique une politique stricte sur les contenus signalés. Les équipes de confiance et sécurité gardent la main avec des outils d’escalade. Enfin, des audits externes assurent la qualité de l’ensemble. Ce circuit doit tourner avec des SLO lisibles et une gouvernance des incidents.

Voici une feuille de route simple à implémenter pas-à-pas:

- 🗂️ Inventorier les flux sensibles et cartographier les points d’entrée.

- 🛠️ Installer des détecteurs multimodaux à l’upload et au partage.

- 🔐 Appliquer des filigranes, des empreintes et des contrôles C2PA sortants.

- 👥 Former des équipes mixtes: modération, legal, data, produit.

- 🧭 Auditer régulièrement avec des tiers et publier des rapports clairs.

Les produits évoluent vite, or la conformité se joue dans les détails quotidiens. Par exemple, la gestion des prompts nécessite une politique de gouvernance. Les modèles doivent refuser fermement les requêtes illicites, tout en expliquant pourquoi. Des ressources pédagogiques comme ce guide d’usage d’un chatbot aident à comprendre les garde-fous côté utilisateur. Sur le front des fonctionnalités sociales, de petits changements d’interface améliorent la sécurité. Un tutoriel de paramétrage, tel que désactiver un indicateur de statut, peut réduire les frictions de confidentialité.

Les roadmaps publiques des grands acteurs génèrent aussi des attentes. Les conférences dévoilent des avancées en IA générative, en synthèse vidéo et en codecs intelligents. Dans ce foisonnement, la transparence devient décisive. Des prévisions et annonces autour de Meta Connect montrent comment les géants articulent innovation et responsabilité. Les plateformes doivent aligner ces innovations avec la réglementation IA sans céder sur la protection des enfants.

Cas pratique: Studio Helios et la mise en conformité

Le Studio Helios, un acteur fictif de création vidéo générative, a revu son architecture. Il a introduit une double barrière: un filtre local au moment du rendu, et un scan déporté avant publication. Les équipes juridiques ont rédigé des politiques claires, tandis que les ingénieurs ont formalisé des SLAs de retrait et de signalement. Le résultat est net: les détournements ont chuté, et les indicateurs de confiance ont progressé. Ce type de ré-architecture prouve qu’un design sérieux porte ses fruits.

Ce blueprint n’isole pas la conformité du produit. Il la fond dans l’expérience, sans alourdir la création légitime. C’est le critère majeur pour durer.

Protection des enfants et éthique numérique: pédagogie, traçabilité et responsabilité partagée

La protection des enfants s’inscrit désormais à tous les niveaux de la chaîne de valeur. Les politiques publiques financent des programmes éducatifs, les plateformes renforcent les contrôles, et les fabricants ajoutent des sécurités dans le silicium. Ce triptyque répond à une réalité: les abus changent de forme, mais ils exploitent toujours les failles d’attention et de coordination. Pour y répondre, il faut de la méthode et des outils clairs.

L’éducation numérique devient un pilier. Les écoles et associations forment à l’analyse des médias. Elles expliquent la notion de contenu illusoire et les manipulations visuelles. Les parents disposent d’outils de suivi et de signalement. Les lignes d’écoute aident à briser l’isolement face aux contenus illicites. Dans ce cadre, les plateformes doivent offrir des parcours de signalement courts et efficaces, avec retour d’information. Une interface claire renforce l’autonomie et le courage de signaler.

La transparence, ensuite, est essentielle. Les rapports périodiques sur les retraits et les demandes d’accès éclairent les décisions. Ils montrent aussi les progrès et les manques. Les entreprises qui communiquent honnêtement gagnent la confiance. Elles protègent leur marque et leurs utilisateurs. Cette clarté soutient la coopération avec les enquêteurs, qui ont besoin d’un historique précis pour agir vite.

Les ONG et les experts techniques jouent un rôle de pivot. Ils apportent des jeux d’essai, des protocoles de test et des retours de terrain. Ils aident à ajuster les filtres sans créer trop de faux positifs. Car la justesse compte autant que la sévérité. Une modération erratique fragilise la crédibilité et lasse les équipes. À l’inverse, une approche mesurée, mais ferme, résiste mieux aux attaques et aux cycles médiatiques.

Enfin, une vigilance constante s’impose sur l’intelligence artificielle embarquée dans les produits du quotidien. Les lunettes connectées, les caméras intelligentes et les assistants domestiques doivent refuser net toute dérive. Les mises à jour de firmware doivent être signées, et les modèles embarqués doivent être surveillés. Les industriels qui intègrent ces exigences gagnent un avantage. Ils réduisent la surface d’attaque et rassurent les familles.

La ligne est claire: l’Union européenne veut une innovation utile, sûre et juste. Les acteurs qui s’alignent sur cette exigence tirent l’écosystème vers le haut. Ils posent un standard, et ils protègent ceux qui comptent le plus.

Qu’impose l’UE aux plateformes qui hébergent des IA génératives ?

Le DSA exige une gestion active des risques, des rapports de transparence et des retraits rapides. L’AI Act ajoute des obligations de documentation, d’audit et de contrôle pour les systèmes d’IA généralistes. Les contenus illicites, dont les vidéos sexuelles impliquant des mineurs, doivent être empêchés, retirés et signalés sans délai.

Pourquoi Grok se retrouve au centre des enquêtes ?

Des utilisateurs ont réussi à contourner ses garde-fous et à produire des contenus illusoires à caractère sexuel. La Commission a donc demandé des explications techniques. Elle vérifie la robustesse des filtres, la traçabilité et le processus de retrait sur X, l’outil étant intégré à la plateforme.

Quels outils techniques aident à la lutte contre la pédopornographie ?

Les plateformes combinent classifieurs multimodaux, watermarking, empreintes C2PA, journaux détaillés et pipelines d’escalade. Elles coopèrent aussi avec des ONG et les autorités, tout en menant des tests adversariaux réguliers pour améliorer la robustesse.

Quel rôle joue le matériel dans la modération temps réel ?

Le choix de GPU, NPU et codecs impacte directement la latence et la précision. Un offload intelligent des prétraitements, des encodages adaptés et une observabilité fine permettent d’atteindre des performances compatibles avec des volumes massifs.

Comment les utilisateurs peuvent-ils agir ?

Ils doivent signaler immédiatement tout contenu suspect, activer les contrôles de confidentialité et s’informer sur les bonnes pratiques. Une sensibilisation à l’éthique numérique et aux contenus illusoires renforce la sécurité collective.