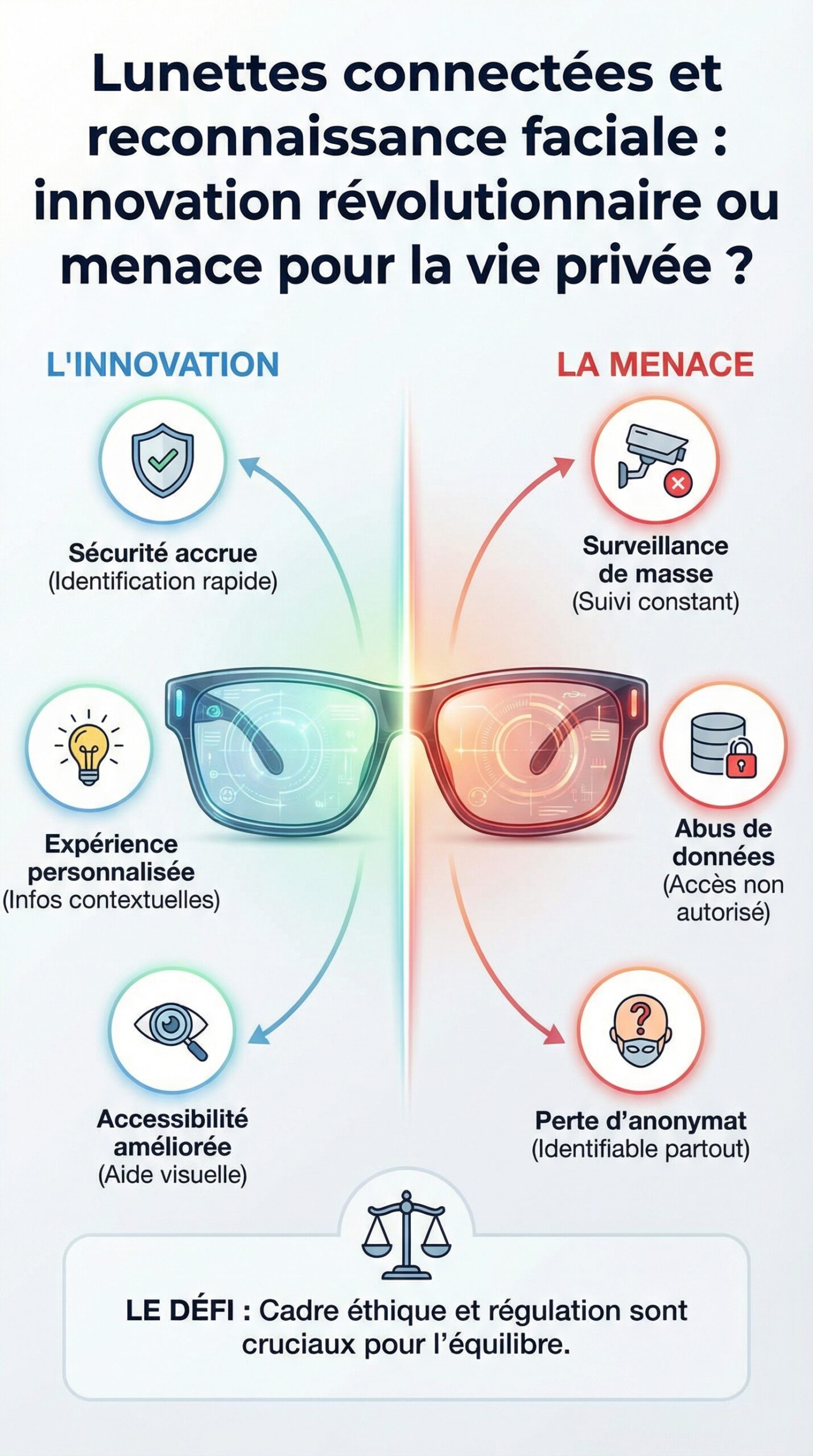

⚡En Bref

- 🕶️ Les lunettes connectées gagnent en autonomie et en IA, ce qui rend la reconnaissance faciale techniquement prête.

- 🔎 La promesse: identifier des personnes “à la volée” et afficher des infos contextuelles; le risque: surveillance diffuse dans l’espace public.

- 🧠 Les débats actuels portent sur l’identification biométrique, le consentement et la protection des données face à une technologie invasive.

- 🧾 Les régulateurs (dont le RGPD) imposent des contraintes, pourtant les usages “gris” restent plausibles via réglages, opt-in, ou intégrations sociales.

- 🔐 Sans garanties fortes de sécurité des données et de transparence, l’éthique devient un critère d’achat aussi important que la fiche technique.

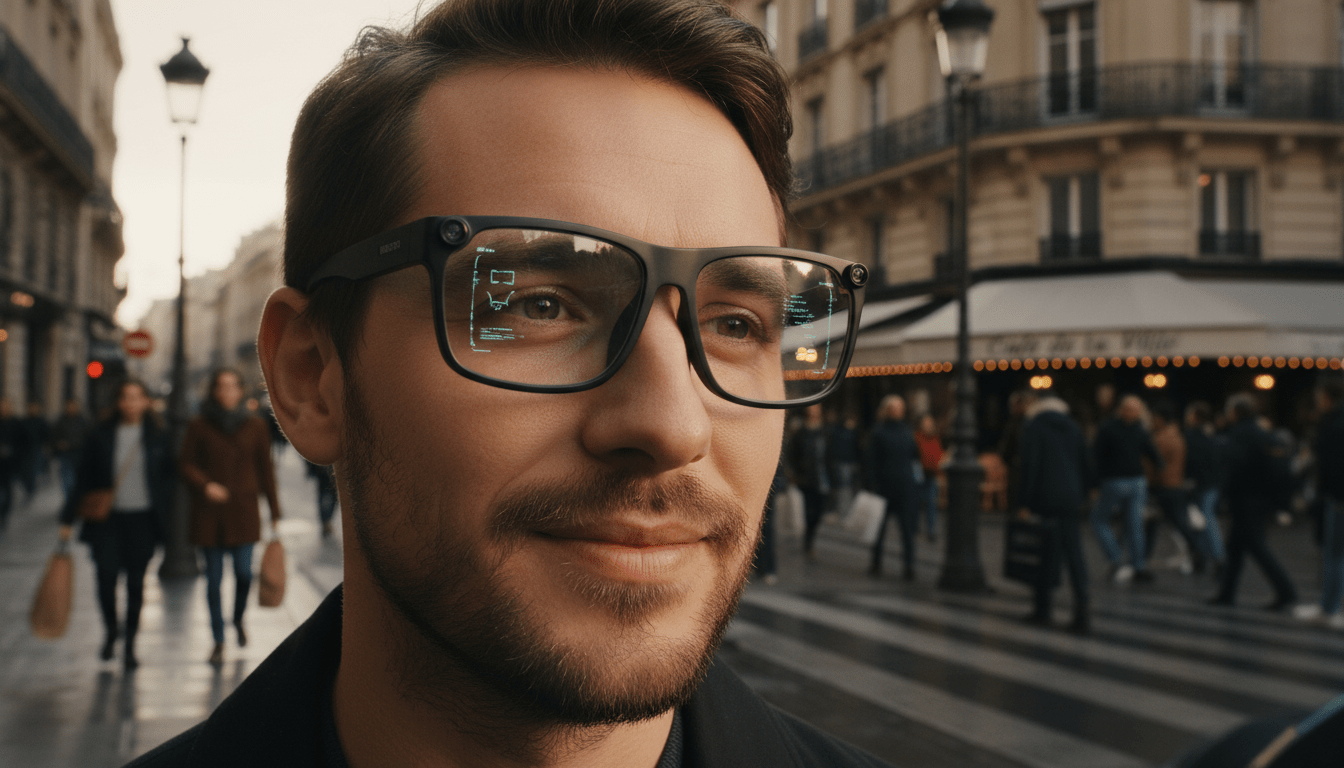

Dans la rue, dans un salon professionnel ou à l’entrée d’un concert, les lunettes connectées ne se contentent plus de filmer. Elles écoutent, décrivent, traduisent, et bientôt, elles pourraient reconnaître. Cette perspective, longtemps repoussée pour des raisons d’acceptabilité sociale, revient au centre du jeu car les briques techniques sont mûres: caméras plus discrètes, IA embarquée plus rapide, et écosystèmes d’applications plus riches.

En parallèle, les signaux venus du marché suggèrent qu’une fonctionnalité de reconnaissance faciale sur des lunettes grand public n’est plus un “et si”, mais un “quand”. Des fuites et notes internes rapportées par la presse américaine évoquent un lancement conditionné par un climat politique jugé favorable. Or, lorsque la surveillance change d’échelle, la question n’est pas seulement technologique. Elle touche la vie privée, la sécurité des données, et la capacité d’une société à fixer des limites à une innovation technologique qui s’invite sur le visage.

Lunettes connectées et reconnaissance faciale : ce que la technologie permet déjà en 2026

Les lunettes intelligentes modernes combinent une caméra grand angle, des microphones, parfois des haut-parleurs à conduction, et une connectivité permanente. Ainsi, elles capturent des scènes “comme les yeux”, ce qui rend l’analyse visuelle plus exploitable que celle d’un smartphone tenu à bout de bras. De plus, l’IA générative embarquée résume, décrit et répond, ce qui prépare naturellement le terrain à l’identification biométrique.

Dans les produits récents, l’amélioration clé vient de la latence. Les traitements qui exigeaient auparavant un cloud lointain se font désormais en partie sur l’appareil ou via un relais local, ce qui accélère l’affichage d’informations contextuelles. Par conséquent, reconnaître un visage, comparer des points caractéristiques, puis proposer un “match” devient un flux quasi continu. Cette fluidité change tout, car l’acte de reconnaissance peut devenir banal.

Un exemple concret aide à comprendre. Sur un salon tech, un porteur de lunettes pourrait regarder un badge, obtenir un nom, puis associer ce nom à un profil social. Ensuite, si le module bascule vers la reconnaissance faciale, l’étape “badge” disparaît. Le résultat devient plus intrusif, car il se déclenche sans signe visible. Et c’est précisément là que le débat démarre.

Les fabricants s’appuient aussi sur une base installée en forte croissance. Meta a communiqué en 2025 avoir dépassé les sept millions d’unités de ses lunettes co-développées avec EssilorLuxottica. Donc, même si seule une fraction active une option sensible, l’impact social peut être massif. Une fonctionnalité “optionnelle” à grande échelle peut produire un effet collectif non optionnel.

Du repérage à l’identification: les briques techniques qui font basculer l’usage

Pour identifier, il faut d’abord détecter. Les algorithmes localisent un visage, évaluent sa qualité, puis extraient un “gabarit” mathématique. Ensuite, ce gabarit est comparé à une base connue, locale ou distante. Enfin, un score de similarité détermine si un nom apparaît. Chaque étape a ses limites, mais l’ensemble fonctionne déjà très bien dans des conditions favorables.

Les contraintes matérielles ont reculé. D’un côté, les capteurs progressent en basse lumière, ce qui étend les situations exploitables. De l’autre, les puces dédiées à l’IA réduisent la consommation, ce qui évite de vider la batterie en une heure. Résultat: une fonctionnalité autrefois réservée à des prototypes peut devenir une option produit. L’insight clé: la faisabilité n’est plus le frein principal.

Une stratégie de déploiement “au bon moment” plutôt qu’une rupture

Les informations rapportées par des médias américains décrivent moins une découverte qu’un arbitrage. Meta s’était déjà retiré d’une approche agressive sur sa plateforme, après des polémiques. En 2021, l’entreprise avait annoncé l’arrêt d’un outil qui analysait systématiquement des visages sur des photos, alors qu’un fichier gigantesque s’était constitué. Aux États-Unis, depuis 2019, Facebook a aussi dû payer environ 7 milliards de dollars d’indemnités et règlements liés à ces pratiques.

Dès lors, la logique “lunettes” peut apparaître comme une relance, mais sous un angle différent. Selon les éléments évoqués, un mémo interne insistait sur l’importance d’un contexte politique favorable pour limiter une mobilisation de l’opinion. Autrement dit, l’enjeu n’est pas que l’outil existe. L’enjeu est qu’il soit accepté. Ce décalage est révélateur: l’innovation technologique avance, tandis que la société tente de rattraper la discussion.

Meta, Name Tag et le marché: promesses d’usage vs risques de surveillance au quotidien

La fonctionnalité évoquée sous le nom de “Name Tag” illustre une promesse séduisante: afficher en temps réel l’identité d’une personne croisée, puis suggérer des informations associées. Dans un cadre professionnel, cela peut améliorer l’accessibilité, notamment pour ceux qui ont des troubles de la mémoire des visages. Toutefois, dans l’espace public, la même capacité peut se transformer en outil de surveillance distribuée.

Pour rendre l’idée tangible, prenons un fil conducteur: une petite agence événementielle fictive, “Atelier Nébula”, équipe deux responsables de production en lunettes intelligentes. Au départ, l’usage est simple: filmer des coulisses, capturer des séquences courtes, et demander à l’IA de résumer des réunions. Ensuite, un module de reconnaissance est proposé pour “mieux gérer les VIP”. À ce stade, l’équipe gagne du temps. Pourtant, le périmètre glisse vite.

En effet, reconnaître un VIP suppose une base de référence. Or, cette base doit être constituée, mise à jour, et sécurisée. De plus, un invité non VIP peut être scanné au passage. Même si l’agence ne le souhaite pas, la mécanique existe. Et si un prestataire externe a accès au flux, la question de la sécurité des données devient centrale.

Les cas d’usage légitimes: accessibilité, assistance, sécurité “consentie”

Certains scénarios sont défendables, à condition d’un consentement clair. Dans une entreprise, une option de reconnaissance limitée aux salariés volontaires peut fluidifier l’accueil. Dans un EHPAD, une aide contextuelle pourrait alerter sur une personne autorisée à entrer, si les familles l’acceptent. Dans un aéroport, une identification peut accélérer un contrôle, mais elle doit rester encadrée et proportionnée.

Le problème tient à la portabilité. Contrairement à une caméra fixe, des lunettes circulent et changent de contexte. Ainsi, une fonction activée “pour le travail” peut suivre son propriétaire au café. Et comme l’interface est discrète, les tiers ne voient pas qu’ils sont analysés. Cette invisibilité fait basculer vers une technologie invasive, même si l’intention initiale est neutre.

Les dérives plausibles: doxxing, pistage social, documentation des fréquentations

Le risque le plus cité reste le doxxing. Un visage identifié peut mener à un nom, puis à des comptes publics, puis à une adresse ou un employeur. Ensuite, un harcèlement peut démarrer. Dans la rue, un simple échange de regard peut devenir une requête. Cette chaîne d’événements transforme une interaction banale en collecte d’informations.

Une autre dérive concerne la cartographie sociale. Si un appareil reconnaît plusieurs personnes au même endroit, il peut inférer des liens. Par conséquent, il devient possible de “documenter” des activités, des interactions, ou des fréquentations. Même sans intention malveillante, la tentation de conserver un historique existe. L’insight final de cette section: le pouvoir d’identification change la nature des relations publiques.

Pour visualiser les enjeux concrets, une démonstration vidéo sur les lunettes intelligentes et l’IA embarquée aide à comprendre les usages et les limites actuelles.

Vie privée, RGPD et protection des données: pourquoi l’identification biométrique change les règles

La vie privée ne se résume pas à “ne rien avoir à cacher”. Elle inclut le droit de circuler sans être catalogué. Or, l’identification biométrique est particulière, car un visage ne se modifie pas comme un mot de passe. Donc, en cas de fuite, la personne concernée ne peut pas “réinitialiser” sa biométrie. C’est pourquoi la protection des données biométriques est traitée comme un sujet à haut risque dans de nombreux cadres réglementaires.

Dans l’Union européenne, le RGPD impose des bases légales, une minimisation, et une transparence renforcée. En pratique, une reconnaissance faciale “générale” dans l’espace public est difficile à justifier. Cependant, les zones grises existent. Une entreprise peut tenter un opt-in via des conditions d’utilisation, ou limiter la comparaison à des contacts. Pourtant, le consentement doit être libre, spécifique et éclairé, ce qui est compliqué quand l’alternative est de “ne pas exister” sur une plateforme dominante.

Un point technique devient vite un point juridique: où se fait la comparaison? Si le matching se fait dans le cloud, l’exposition augmente, car les données transitent. À l’inverse, un traitement local réduit certains risques, mais il n’annule pas la question du droit à l’image et du consentement des tiers. En somme, la localisation du calcul ne résout pas le problème social. Elle déplace simplement les menaces.

Consentement des personnes scannées: l’angle mort de l’espace public

Dans une conversation, il est possible de demander l’accord pour enregistrer. Dans une foule, c’est impraticable. Ainsi, la reconnaissance “à la volée” repose souvent sur une asymétrie: l’utilisateur choisit, les passants subissent. Même si une LED signale l’activité, l’information reste limitée, car elle ne dit pas “analyse faciale en cours”. De plus, les gens ne savent pas quoi faire pour refuser.

Cette asymétrie pose un défi d’éthique. La norme sociale pourrait glisser vers une acceptation fataliste, surtout si le déploiement se fait dans une période politique chargée, quand l’attention se disperse. À ce moment-là, l’adoption peut se stabiliser avant le débat. L’insight à retenir: le timing d’un lancement peut façonner la norme plus que la loi.

Sécurité des données: de la fuite de modèles aux abus d’accès

Les risques ne se limitent pas au piratage de vidéos. Il faut aussi considérer les accès internes, les partenaires, et les applications tierces. Une base de visages, même partielle, devient une cible. De plus, des modèles d’IA peuvent être détournés, par exemple via extraction d’embeddings ou ré-identification. Par conséquent, la sécurité des données exige des contrôles: chiffrement, journalisation, et segmentation stricte.

Un cas plausible: “Atelier Nébula” confie la gestion des invités à un prestataire. Ce prestataire conserve des gabarits pour “améliorer la qualité”. Ensuite, un employé malveillant exporte la liste. Ici, la faille n’est pas une attaque sophistiquée. C’est une mauvaise gouvernance. L’idée clé: la sécurité dépend autant des processus que des puces.

Pour ancrer ces questions dans le débat public, il est utile de revoir comment les controverses passées autour de lunettes connectées ont émergé, notamment avec les Google Glass et leurs usages en public.

Comparatif des lunettes connectées: capteurs, IA, discrétion et risques de technologie invasive

Les lunettes intelligentes ne se valent pas. Certaines se concentrent sur la capture photo/vidéo, tandis que d’autres poussent l’assistance IA. De plus, la discrétion du design influence directement le potentiel de surveillance. Une monture proche de lunettes classiques attire moins l’attention, ce qui peut augmenter le risque d’abus. À l’inverse, un design plus visible peut créer une friction sociale, mais il informe mieux les tiers.

Sur le marché, les Ray-Ban Meta dominent la conversation car elles ont atteint une échelle grand public. Elles mettent en avant des vidéos courtes, une intégration sociale, et des fonctions IA. D’autres acteurs, eux, misent sur des usages “pro”: assistance en entrepôt, téléassistance, ou affichage de procédures. Pourtant, la frontière entre pro et grand public s’amincit. Et quand une option logicielle suffit à basculer, le risque suit le matériel.

Ce qu’un test rigoureux doit mesurer, au-delà des specs

Un protocole de test pertinent ne doit pas se limiter à l’autonomie ou à la qualité audio. Il doit aussi mesurer la transparence d’usage. Par exemple, l’appareil signale-t-il clairement l’enregistrement? Les réglages sont-ils compréhensibles? Les données sont-elles exportables, et surtout supprimables? Enfin, l’utilisateur peut-il désactiver physiquement caméra et micros?

Dans un test “terrain”, un point ressort souvent: la tentation de tout activer. Une commande vocale rapide suffit. Ensuite, l’habitude s’installe. C’est pourquoi l’ergonomie devient un sujet de protection des données. Quand la désactivation est pénible, la collecte devient la norme. L’insight final: la UX peut favoriser ou freiner une technologie invasive.

Liste de contrôle avant achat: usages, réglages et garde-fous 🔐

Avant de choisir une paire, quelques critères concrets aident à limiter les risques, tout en profitant de l’innovation technologique. Cette liste sert de base, puis elle se complète selon le contexte.

- 🟢 Vérifier la présence d’un indicateur visible d’enregistrement (LED, son, message), et sa désactivation possible ou non.

- 🛑 Exiger un interrupteur matériel pour caméra/micro, plutôt qu’un simple bouton logiciel.

- 🔐 Contrôler les options de sécurité des données (chiffrement, verrouillage, effacement à distance).

- 📦 Lire la politique de protection des données: durée de conservation, partage, et sous-traitants.

- 🧭 Évaluer la discrétion du design: plus c’est invisible, plus le risque de surveillance sociale augmente.

- 👥 Examiner les réglages liés aux contacts: reconnaissance limitée aux proches, opt-in, et exclusions.

- ⚖️ Rechercher les engagements d’éthique: audits, rapports de transparence, et bug bounty.

Avec ces repères, le débat se déplace: il ne s’agit plus seulement de performance, mais d’un choix de société au moment de passer en caisse.

Gouvernance, éthique et garde-fous: comment éviter que la reconnaissance faciale devienne la norme

Des garde-fous crédibles reposent sur trois couches: technique, contractuelle, et sociale. Côté technique, un traitement local réduit l’exposition, mais il doit être accompagné d’un contrôle d’accès strict. Côté contractuel, des conditions d’utilisation claires et des sanctions contre les abus sont nécessaires, mais elles restent insuffisantes si la détection est difficile. Enfin, côté social, des normes émergent: lieux “sans enregistrement”, signalétiques, et refus explicites.

Les leçons du passé sont utiles. Les Google Glass avaient déclenché une réaction forte dans certains lieux, au point de rendre le produit socialement “bruyant”. La vente grand public avait été stoppée, et le projet a fini par être abandonné dans sa forme initiale. Aujourd’hui, les lunettes sont plus banales, donc la friction diminue. Par conséquent, les garde-fous doivent être plus solides qu’un simple rejet social spontané.

Mesures techniques: minimisation, preuves d’effacement, et limites d’usage

Un cadre sérieux peut imposer une minimisation stricte. Par exemple, interdire la conservation par défaut, ou limiter la comparaison à une base locale chiffrée. De plus, des “preuves d’effacement” pourraient être proposées, via journaux vérifiables. Ensuite, un plafonnement des requêtes de reconnaissance réduirait les usages de type balayage de foule. Ces mécanismes ne règlent pas tout, mais ils augmentent le coût de l’abus.

Une autre piste consiste à intégrer des zones sensibles. Dans certains lieux, une géorestriction pourrait désactiver certaines fonctions. Toutefois, cette approche exige de la confiance dans l’opérateur. Et si l’utilisateur modifie le logiciel, la barrière tombe. L’insight clé: les limites techniques doivent être auditables, sinon elles restent marketing.

Responsabilité des plateformes et “moment politique”: l’enjeu de la transparence

Quand des documents internes évoquent un lancement lors d’une période politiquement troublée, cela soulève une question simple: qui décide du tempo? La transparence devient donc un critère de gouvernance. Un rapport public sur les tests, les biais, et les garde-fous devrait être standard. De même, un mécanisme de plainte accessible aux personnes scannées serait nécessaire, même si elles ne sont pas clientes.

Dans le cas de “Atelier Nébula”, la bonne pratique serait d’afficher une signalétique claire lors des événements, et de proposer une alternative. Par exemple, un bracelet “no scan” et une consigne interne. Ce type de démarche ne résout pas la question globale, mais il montre une direction. L’insight final: la confiance se construit par des contraintes visibles, pas par des promesses.

La reconnaissance faciale sur des lunettes connectées fonctionne-t-elle sans Internet ?

Oui, en partie, si l’appareil dispose d’une puce IA et d’une base locale. Cependant, dès qu’une comparaison avec des profils en ligne est proposée, une connexion redevient probable. Dans tous les cas, l’absence d’Internet ne supprime pas l’enjeu de vie privée, car la capture et l’analyse peuvent rester locales.

Pourquoi parle-t-on d’identification biométrique plus risquée qu’un simple enregistrement vidéo ?

Parce qu’un visage peut servir de “clé” persistante. Une vidéo montre une scène, alors qu’une identification biométrique relie une personne à un nom, puis à des données. De plus, en cas de fuite, un visage ne se change pas comme un mot de passe, ce qui augmente l’impact sur la protection des données.

Quelles garanties minimales exiger pour protéger la vie privée des passants ?

Au minimum: un indicateur visible d’enregistrement, un interrupteur matériel, une conservation limitée, des réglages compréhensibles, et un engagement clair sur la sécurité des données. Ensuite, un mécanisme de plainte et des audits indépendants renforcent la crédibilité. Sans cela, la technologie invasive peut s’installer sans consentement réel.

Meta peut-il limiter la reconnaissance faciale aux contacts d’un réseau social ?

Techniquement, oui, via une comparaison restreinte à une liste de contacts ou à des profils ayant opté pour l’option. Toutefois, le point critique reste le consentement des personnes scannées dans l’espace public. Même limitée, une fonction de reconnaissance faciale peut créer une pression sociale et des effets de surveillance.