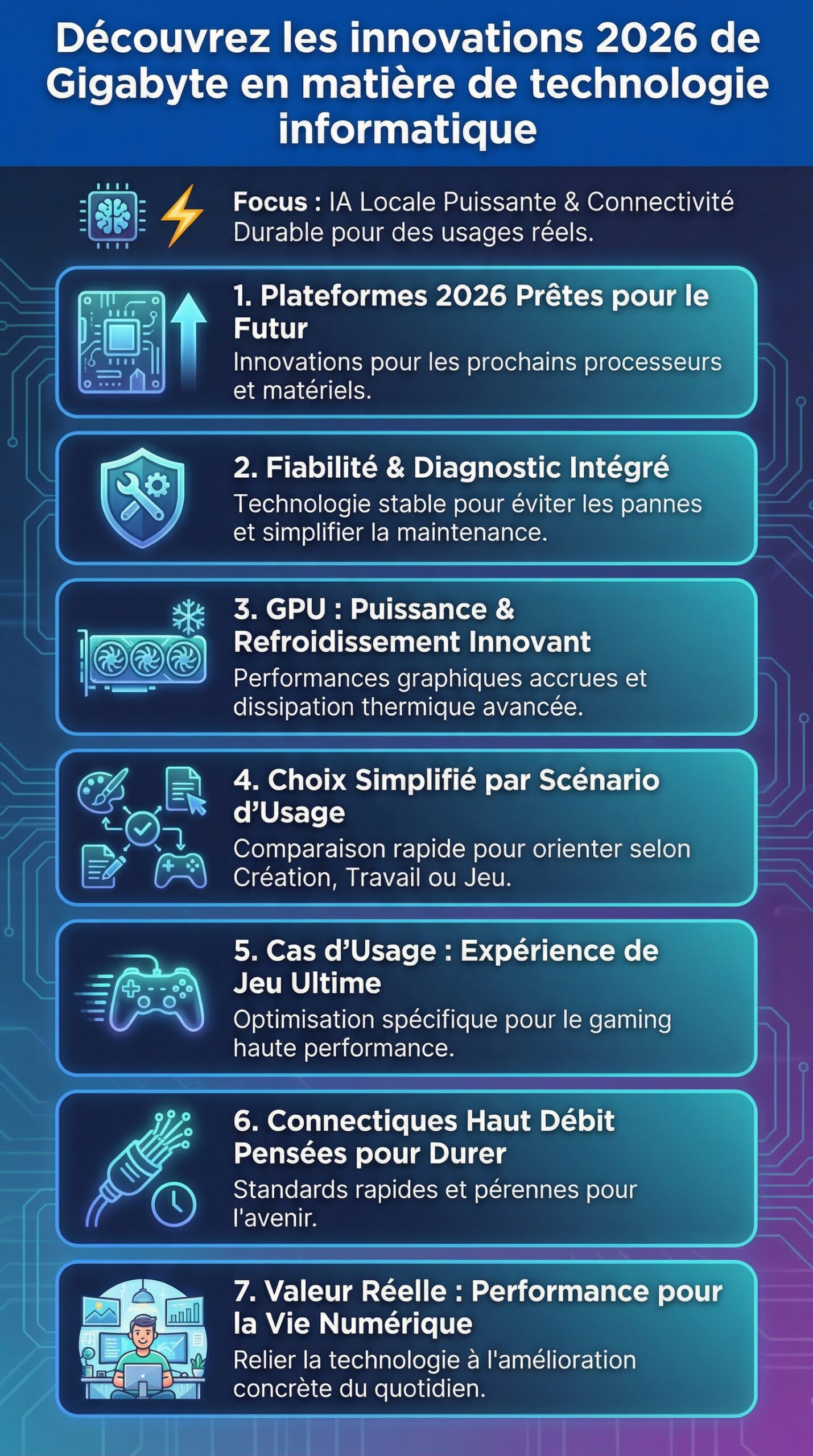

Sur le marché du matériel informatique, Gigabyte avance souvent là où les usages se transforment d’abord. Cette dynamique se lit dans des choix concrets, comme la montée en puissance des plateformes orientées IA locale, ou encore la généralisation des connectiques haut débit pensées pour durer. Pourtant, une innovation n’a de valeur que si elle améliore vraiment la vie numérique, que ce soit pour jouer, créer, travailler ou administrer un parc. C’est précisément sur ce terrain que les annonces et orientations récentes de Gigabyte prennent du relief, car elles relient les performances à la fiabilité, et la technologie à des scénarios réels.

Dans un futur numérique dominé par des flux toujours plus lourds, la question n’est plus seulement “combien de FPS” ou “combien de cœurs”. Il faut aussi parler d’efficacité énergétique, de stabilité en charge, de bruit, de maintenance, et même de cadence de mise à jour des firmwares. Ainsi, la lecture des nouveautés Gigabyte gagne à être structurée par profils d’utilisateurs. Un studio de montage, un joueur compétitif, un data scientist et un responsable IT n’attendent pas les mêmes gains, ni les mêmes compromis. En reliant ces besoins à des évolutions tangibles, le panorama devient plus utile, et surtout plus actionnable.

En Bref

- Innovations Gigabyte axées sur l’IA locale, la connectique haut débit et la stabilité en charge, afin d’augmenter les performances sans sacrifier la fiabilité.

- Cartes mères et écosystèmes logiciels mieux pensés pour les processeurs récents, avec une attention forte portée au VRM, au refroidissement et au diagnostic.

- Évolutions côté cartes graphiques : refroidissement, acoustique, profils de puissance, et intégration plus simple dans des boîtiers compacts.

- Approche plus “usage” pour le PC moderne : créateurs, joueurs, IA personnelle, et petites infrastructures, pour préparer le futur numérique.

- Comparatifs et méthodes de test : latence, stabilité, bruit, températures, et consommation, car la fiche technique ne suffit plus.

Cartes mères Gigabyte 2026 : innovations de plateforme pour processeurs et matériel informatique

Le premier levier d’une configuration moderne reste la carte mère, car elle conditionne la stabilité et l’évolutivité. Chez gigabyte, les innovations se lisent d’abord dans la qualité d’alimentation et dans la manière de piloter les nouveaux processeurs. Ainsi, le VRM n’est plus seulement un argument marketing. Il devient un outil de stabilité sous charge IA, rendu 3D et sessions de jeu longues. Par conséquent, un design d’étages d’alimentation mieux dimensionné limite les chutes de tension et réduit la chauffe sur la durée.

Ensuite, la connectique prend un rôle central, car le stockage rapide et les périphériques externes gagnent en importance. Pour un créateur vidéo, la différence entre un projet “fluide” et un projet “pénible” tient souvent à la vitesse du SSD et au débit d’un port externe. De ce fait, une carte mère orientée productivité doit offrir plusieurs emplacements NVMe, des dissipateurs sérieux, et un routage propre. De plus, la qualité du réseau filaire et sans fil devient un critère prioritaire, car les workflows s’appuient sur le NAS et le cloud hybride.

Stabilité, diagnostic et maintenance : la technologie qui évite les pannes

Un point sous-estimé concerne la capacité à diagnostiquer vite, car une panne coûte plus qu’un composant. Gigabyte pousse donc des outils de debug plus accessibles, avec LED de diagnostic, affichage de codes, et journaux d’événements plus lisibles. De même, la gestion des profils mémoire et des mises à jour UEFI gagne en clarté, ce qui réduit les erreurs de configuration. En pratique, un intégrateur peut déployer une série de machines avec moins d’allers-retours, tout en gardant des réglages cohérents.

Un exemple simple illustre l’intérêt : une petite agence fictive, “Atelier Nord”, monte dix stations pour de la retouche et du motion design. Or, des crashes intermittents en export peuvent venir d’un réglage mémoire trop agressif. Avec des profils mieux validés et un diagnostic plus direct, l’équipe corrige plus vite et évite des heures de rendu perdues. Au final, la technologie devient un filet de sécurité, pas seulement une course aux chiffres.

Comparaison rapide : orienter le choix selon l’usage

Pour guider un achat, une comparaison structurée aide plus qu’une avalanche de spécifications. Le tableau ci-dessous met en regard des priorités fréquentes, car un PC de jeu n’a pas le même cahier des charges qu’une station de création. Ainsi, le lecteur peut relier les innovations à un besoin clair, puis arbitrer budget et évolutivité.

| Profil | Priorité carte mère | Pourquoi c’est décisif | Point de vigilance |

|---|---|---|---|

| Jeu compétitif | Latence et stabilité réseau | Ping régulier, moins de micro-coupures | Drivers et réglages QoS |

| Création vidéo | Stockage NVMe et ports haut débit | Cache, proxies, transferts rapides | Températures SSD en charge |

| IA locale | Alimentation CPU/RAM robuste | Charges longues, risques d’instabilité | Refroidissement VRM |

| PME / IT | Gestion et diagnostic | Temps de maintenance réduit | Politiques de mise à jour |

En somme, une carte mère moderne ne se juge plus uniquement à sa compatibilité. Elle se juge à sa capacité à tenir la charge, à être maintenable, et à rester pertinente face au futur numérique.

Cartes graphiques Gigabyte : performances, refroidissement et innovations pour le futur numérique

Les cartes graphiques restent la vitrine des performances, cependant l’époque où seul le “nombre” comptait s’éloigne. Les innovations attendues se concentrent sur trois points : efficacité, acoustique, et constance des fréquences. Ainsi, un modèle bien conçu maintient une cadence stable sans oscillations brutales, ce qui améliore le confort en jeu et en création. De plus, la maîtrise des pics de consommation devient un avantage pratique, car elle limite les exigences sur l’alimentation et la ventilation du boîtier.

La qualité du refroidissement pèse aussi sur la durabilité. Une solution efficace ne se résume pas à de gros ventilateurs, car la répartition de chaleur et la qualité des pads thermiques comptent. Chez gigabyte, la différenciation passe souvent par des designs de dissipateurs et des profils ventilateurs plus nuancés. Par conséquent, un PC haut de gamme peut rester discret tout en encaissant des charges prolongées, comme un rendu Blender ou un entraînement léger de modèles.

Cas d’usage : jeu, création, IA locale

Dans un titre exigeant, une carte graphique stable réduit les micro-saccades, donc l’expérience paraît plus “solide”. À l’inverse, en montage, l’accélération GPU se traduit par des timelines plus fluides et des exports plus courts. Enfin, l’IA locale exploite massivement la mémoire vidéo, ce qui rend la capacité VRAM et sa gestion thermiquement stable particulièrement importantes. Ainsi, une même famille de GPU peut viser des publics différents, à condition que l’intégration soit cohérente.

Pour illustrer, un streamer fictif, “Mika”, joue en haute résolution tout en encodant et en appliquant des filtres. Dans ce scénario, le GPU ne doit pas seulement être rapide. Il doit rester prévisible, car un pic thermique peut déclencher une hausse de bruit, puis une baisse de fréquence. En conséquence, une innovation utile est celle qui lisse le comportement, pas celle qui brille sur un benchmark de 30 secondes.

Méthode de test rigoureuse : ce qui compte vraiment

Pour juger une carte, il faut des tests répétés et des mesures comparables. Par exemple, une session de 20 minutes dans une scène lourde révèle mieux les écarts qu’un test court. Ensuite, la mesure du bruit à distance fixe et dans une pièce silencieuse donne un indicateur concret. Enfin, la surveillance des fréquences en continu met en lumière la stabilité, donc la qualité thermique. Ces critères servent directement l’utilisateur, car ils décrivent le comportement réel.

- Température GPU et température mémoire après 20 minutes de charge.

- Niveau sonore en dBA à distance fixe, à charge et au repos.

- Stabilité des fréquences : courbe, pas seulement la valeur maximale.

- Consommation moyenne et pics, pour dimensionner l’alimentation.

- Performances en jeu, en création et en calcul, pour éviter un choix biaisé.

En définitive, l’innovation la plus rentable est souvent celle qui rend la puissance utilisable, stable et silencieuse, ce qui ancre la carte graphique dans le futur numérique plutôt que dans la simple démonstration.

Ces tests vidéo aident à visualiser les écarts de bruit et de températures, car les chiffres seuls ne racontent pas toujours l’histoire complète.

PC IA et productivité : innovations Gigabyte en technologie informatique pour l’usage quotidien

Le PC orienté IA locale ne relève plus de la curiosité, car de nombreux usages deviennent accessibles hors cloud. Cette évolution change la manière de choisir le matériel informatique. Il ne suffit pas d’avoir un bon GPU. Il faut aussi un CPU solide, une RAM stable, et un stockage rapide pour alimenter les pipelines. Dans cette optique, les innovations côté gigabyte se lisent dans l’écosystème : BIOS plus intelligents, profils d’énergie, et outils de supervision plus accessibles. Ainsi, l’utilisateur peut viser un ordinateur “efficace” plutôt qu’un ordinateur “survolté”.

La technologie utile se mesure alors au temps gagné et aux frictions supprimées. Par exemple, un assistant local de transcription peut tourner en tâche de fond pendant une visio. Ensuite, un outil de tri photo basé sur l’IA accélère la sélection d’un reportage. Enfin, un petit modèle de génération de texte peut aider à reformuler un document hors connexion. Dans ces cas, la constance des performances compte davantage que le pic maximal, car l’usage s’étire sur des heures.

Exemple concret : une station “créa + IA” équilibrée

Un poste polyvalent doit rester cohérent. D’abord, le CPU gère les tâches mixtes, comme l’encodage, les scripts et l’export. Ensuite, le GPU accélère les effets et les inférences. De plus, la RAM évite les swaps sur disque, ce qui protège les SSD et améliore la réactivité. Enfin, une alimentation de qualité stabilise l’ensemble, surtout quand la charge varie vite. Ainsi, les choix de plateforme et de composants se justifient par l’usage, pas par une fiche produit.

Une anecdote parle d’elle-même : dans un petit studio fictif, “Kadrage”, un monteur a constaté des ralentissements lors d’un lot de transcriptions. Le problème venait d’un SSD secondaire sans dissipateur qui throttlaisait. Après migration vers un emplacement NVMe mieux refroidi et ajustement du flux d’air, les délais ont chuté, tandis que le bruit est resté modéré. Par conséquent, l’innovation n’est pas forcément spectaculaire. Elle peut être un détail de conception qui change la journée de travail.

Connectique et réseau : le nerf des workflows modernes

Les flux créatifs transitent de plus en plus via des serveurs locaux ou des liens rapides. Par conséquent, le réseau n’est plus un accessoire. Il devient le prolongement du stockage. De même, les ports rapides facilitent la vie des photographes et vidéastes qui importent des médias lourds. Ainsi, une plateforme bien équipée réduit les manipulations, donc les erreurs. Et comme les projets se multiplient, cette simplicité devient un avantage compétitif.

Cette orientation vers des usages concrets prépare le terrain pour la suite : comment mesurer et comparer ces gains, sans se contenter d’un benchmark isolé. C’est là que la méthode devient aussi importante que le produit.

Une démonstration de configuration IA met en évidence les choix d’équilibrage, notamment entre processeurs, cartes graphiques, mémoire et refroidissement.

Tests et comparatifs : mesurer les performances Gigabyte sur le matériel informatique réel

Comparer du matériel informatique demande une méthode stable, sinon les résultats deviennent anecdotiques. Une approche sérieuse commence par définir des scénarios reproductibles. Ensuite, il faut mesurer la température ambiante, car elle influence directement le refroidissement. De plus, il convient d’utiliser les mêmes versions de pilotes et les mêmes réglages, car un simple paramètre peut fausser un graphique. Ainsi, les innovations se voient dans la constance, pas dans un chiffre isolé.

Dans le cas des plateformes gigabyte, la qualité se lit souvent dans des détails : temps de boot régulier, profils mémoire qui tiennent, et absence d’erreurs sous charge mixte. Par conséquent, les tests doivent inclure des sessions longues, comme une boucle de rendu et un jeu gourmand, lancés l’un après l’autre. De même, un test réseau et stockage révèle les points faibles qui échappent aux benchmarks classiques. L’objectif reste simple : savoir si la machine “tient” dans la vraie vie.

Protocole recommandé : du synthétique au réel

Un protocole équilibré combine des outils standards et des tâches réelles. D’abord, un test CPU mesure les gains liés aux processeurs. Ensuite, des scènes 3D et des jeux évaluent les cartes graphiques. Enfin, des transferts de fichiers et une compilation de projet mesurent la plateforme globale. Ainsi, les performances deviennent comparables entre machines, tout en restant proches des usages. Et comme les écarts se jouent parfois à 5%, la rigueur protège le lecteur contre les conclusions hâtives.

Une comparaison utile ne doit pas oublier le bruit. En effet, une configuration très rapide mais bruyante peut être un mauvais achat pour un bureau. De plus, la consommation est redevenue un critère, car elle influence la chaleur et la facture. En conséquence, une bonne fiche de test inclut la charge et le repos, avec mesures répétées. Cette discipline donne une lecture fiable des innovations.

Ce que révèlent les tests : stabilité, évolutivité, confort

Quand une plateforme est bien née, les scores montent, mais surtout ils restent stables. Par exemple, une carte graphique qui conserve sa fréquence après 30 minutes est plus agréable qu’un modèle qui chute. De même, une carte mère qui gère la mémoire sans erreurs évite des crashs difficiles à diagnostiquer. Enfin, une bonne gestion des ventilateurs améliore l’expérience au quotidien. Ainsi, la technologie devient “invisible”, ce qui est souvent le signe d’un produit mature.

Ce regard par la preuve prépare naturellement la question suivante : comment ces innovations s’inscrivent dans les tendances du secteur, et comment anticiper les prochains achats sans se tromper de cycle.

Tendances 2026 et stratégie Gigabyte : innovations informatique entre durabilité, efficacité et futur numérique

Le secteur informatique se réorganise autour de trois contraintes : énergie, densité et souveraineté des usages. D’abord, l’énergie impose de chercher l’efficacité, pas seulement la puissance. Ensuite, la densité pousse vers des boîtiers plus compacts, donc vers des composants mieux refroidis. Enfin, la souveraineté encourage l’IA locale et le stockage privé, ce qui change la valeur du PC. Dans ce contexte, les innovations gigabyte prennent une dimension stratégique, car elles touchent la plateforme complète, du firmware au refroidissement.

Le futur numérique ne se limite plus aux jeux. Il englobe la création, l’automatisation, la sécurité, et l’apprentissage. Par conséquent, une entreprise ou un particulier cherche des machines capables d’évoluer. Cela implique des cartes mères avec une connectique pérenne, des options réseau solides, et une marge thermique suffisante. De même, le suivi logiciel devient crucial, car un BIOS et des pilotes bien maintenus prolongent la durée de vie. Ainsi, la durabilité devient une innovation à part entière.

Durabilité et réparabilité : l’argument qui monte

Les composants haut de gamme coûtent cher, donc l’utilisateur exige une longévité réelle. Cela passe par des matériaux, mais aussi par une conception qui limite les points chauds. Par ailleurs, une bonne documentation et des outils de diagnostic aident à réparer, ou au moins à isoler une panne. En conséquence, l’achat devient moins risqué. Et comme les cycles de renouvellement s’allongent, cet aspect prend du poids dans la décision.

Un exemple courant concerne les boîtiers compacts. Dans un mini-PC puissant, la chaleur s’accumule vite. Ainsi, une carte graphique avec un refroidissement bien pensé et une courbe ventilateur adaptée fait la différence. De même, une carte mère avec dissipateurs efficaces évite des throttlings cachés. Ces détails, parfois discrets, dessinent une expérience plus sereine sur plusieurs années.

Que surveiller avant d’acheter : une grille simple

Pour rester concret, certains critères doivent guider le choix, car ils conditionnent les performances réelles. D’abord, la compatibilité des processeurs et la qualité d’alimentation. Ensuite, l’espace et la ventilation selon la carte graphique visée. De plus, la connectique stockage et réseau selon les usages. Enfin, le support logiciel et la facilité de mise à jour. Cette grille réduit les achats impulsifs, tout en alignant la machine sur un usage réel.

Au final, les innovations qui comptent sont celles qui rendent la puissance exploitable, stable et durable, ce qui prépare efficacement l’utilisateur au futur numérique.

Quelles innovations Gigabyte apportent le plus de gain au quotidien ?

Les gains les plus visibles viennent souvent de la stabilité de plateforme (VRM, profils mémoire, diagnostics), de la connectique rapide pour le stockage, et d’un refroidissement mieux maîtrisé. Ainsi, les performances restent constantes, tandis que le bruit et les baisses de fréquence diminuent.

Comment choisir entre plusieurs cartes graphiques Gigabyte pour jouer et créer ?

Il faut comparer la stabilité en charge longue, la température mémoire, le niveau sonore et la consommation, pas seulement les FPS moyens. Ensuite, la quantité de VRAM devient déterminante pour la création et l’IA locale, alors qu’en jeu compétitif la latence et la régularité priment.

Quels tests permettent de vérifier la fiabilité d’une configuration ?

Des charges longues et mixtes sont essentielles : boucle de rendu, jeu exigeant, transferts NVMe, puis surveillance des fréquences, des erreurs mémoire et des températures. De plus, une mesure de bruit et une vérification des pics de consommation donnent une image plus réaliste du comportement.

Pourquoi la connectique et le réseau sont-ils devenus si importants en informatique ?

Les projets sont plus lourds et circulent entre SSD, NAS et services cloud. Par conséquent, des ports haut débit et un réseau stable réduisent les temps de transfert et les frictions. Cette amélioration se ressent immédiatement dans la productivité, donc elle vaut souvent plus qu’un petit gain de benchmark.