En Bref

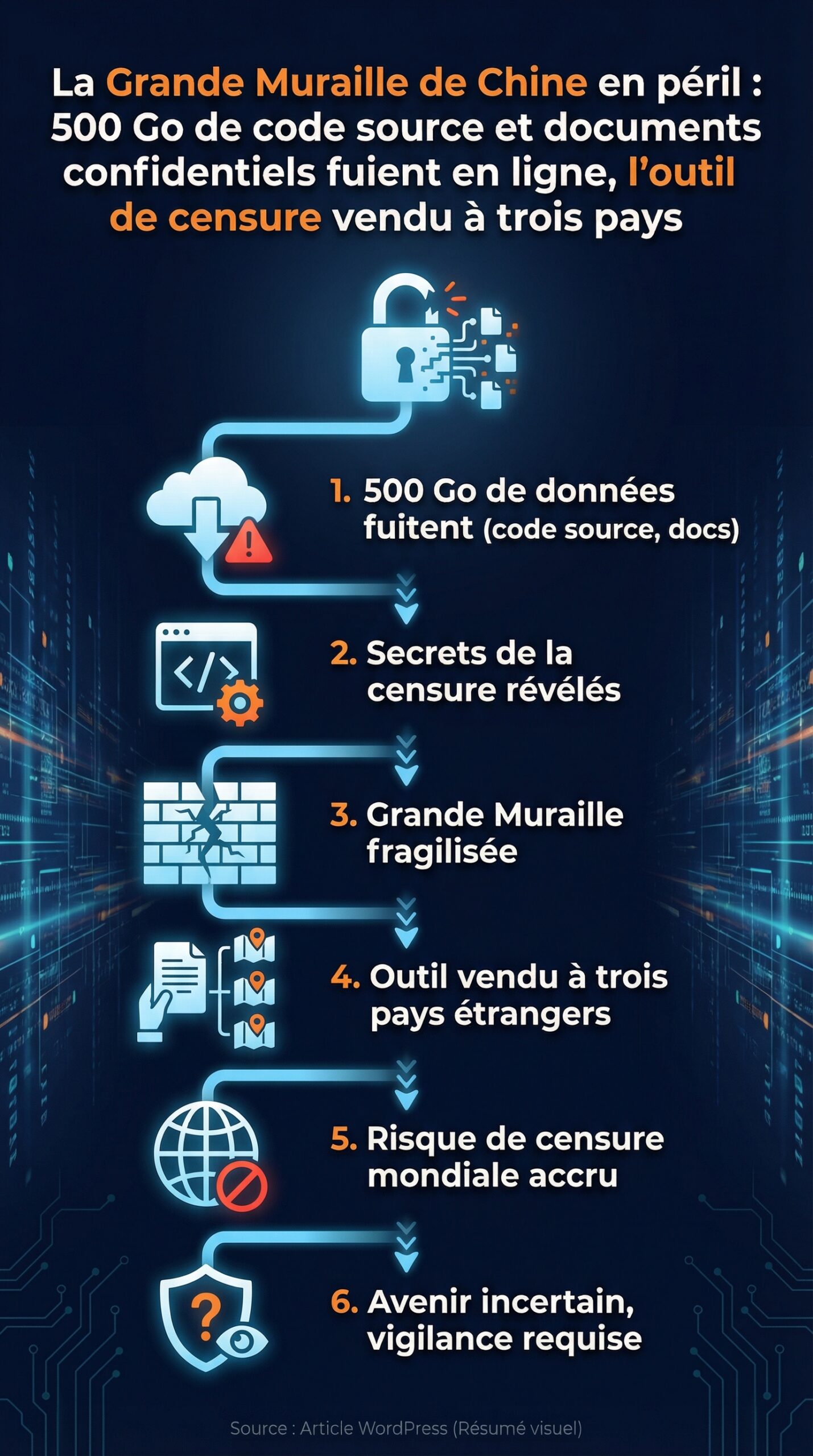

- Une fuite en ligne de plus de 500 Go expose du code source, des documents confidentiels, des journaux et des procédures liées au filtrage national chinois.

- Les archives décrivent une plateforme industrialisée, souvent présentée comme une Grande Muraille de Chine numérique “clé en main”, pensée pour l’inspection profonde des paquets et la détection de VPN.

- La fuite éclaire la vente d’un outil de censure à trois pays au moins, et relance le débat entre cybersécurité, souveraineté et risques d’espionnage.

Un lot massif de données techniques attribuées à l’écosystème du “Grand Pare-feu” chinois a brusquement déplacé le débat, du terrain politique vers l’atelier d’ingénierie. Derrière le symbole de la Grande Muraille de Chine, la mécanique de filtrage d’Internet repose sur des chaînes de compilation, des consoles d’exploitation, des signatures réseau et des bibliothèques d’analyse de trafic. Or, lorsqu’un ensemble de documents confidentiels et de code source s’échappe, ce n’est pas seulement l’image qui vacille. Ce sont aussi des pratiques, des dépendances matérielles, et des méthodes d’intégration chez les opérateurs qui se retrouvent exposées.

Le dossier est d’autant plus sensible qu’il ne s’agit pas d’un simple échantillon. Les chercheurs qui ont indexé l’archive évoquent plus de 500 Go de dépôts et de notes internes. La fuite révèle une logique de produit, avec guides de déploiement, supervision de sessions à grande échelle, et modules orientés vers la détection de contournements. Dans un contexte où l’exportation d’équipements DPI s’accélère, l’épisode met aussi en lumière la dimension commerciale : l’outil de censure ne se limite plus à un usage domestique, et la vente à trois pays rebat les cartes de la cybersécurité régionale.

La “Grande Muraille de Chine” numérique en péril : anatomie d’une fuite en ligne à 500 Go

Le premier point à comprendre tient à la nature même des fichiers. Une fuite de cette taille ne correspond pas à un “dossier oublié” sur un serveur. Au contraire, elle suggère l’extraction de dépôts complets, avec historique de build, scripts d’automatisation et documentation opérationnelle. Ainsi, lorsque des archives contiennent à la fois code source, journaux d’exploitation et consignes d’escalade, elles décrivent une organisation, pas seulement un programme.

Dans ce cas, les éléments publiés renvoient à une chaîne technique de filtrage national : inspection profonde des paquets (DPI), corrélation de sessions, et règles de détection centrées sur les outils de contournement. Par conséquent, le péril ne se limite pas à la divulgation d’algorithmes. Il touche aussi les “habitudes” d’exploitation : nommage interne, emplacements de journaux, seuils d’alerting, et procédures de maintenance. Or, ces détails font souvent la différence entre un système opaque et un système attaquable.

Ce que des journaux et des runbooks changent en cybersécurité

Dans un incident classique, le code source attire l’attention. Pourtant, les runbooks et les journaux valent parfois davantage. D’une part, ils expliquent comment les équipes réagissent aux pannes. D’autre part, ils révèlent les angles morts : dépendances à un service, limites de capacité, ou alertes ignorées. Dès lors, l’attaque la plus efficace n’est pas forcément cryptographique. Elle peut viser l’opérationnel, par exemple en provoquant des flux qui saturent des tables d’état.

Pour illustrer, il suffit d’imaginer un opérateur fictif, “OrchidNet”, chargé d’intégrer une passerelle de filtrage sur un point d’échange Internet. Si un adversaire connaît la logique de rotation des logs et les seuils de déclenchement, il peut orchestrer un bruit qui masque un trafic ciblé. En pratique, ce type de stratégie s’observe déjà dans des attaques de diversion. Cette fois, la fuite donne une cartographie plus précise, ce qui augmente mécaniquement le risque d’espionnage technique.

Origines industrielles et liens de recherche : un empilement d’acteurs

Les analyses publiques relient l’archive à un fournisseur associé de longue date à l’écosystème du filtrage, ainsi qu’à un laboratoire de recherche rattaché à un institut spécialisé. Ce duo est important, car il montre une circulation entre R&D et production. Autrement dit, les prototypes de détection deviennent des modules déployés, puis se retrouvent documentés pour l’exploitation. En conséquence, la fuite décrit non seulement “ce qui marche”, mais aussi ce qui a été testé, abandonné, puis amélioré.

Cette lecture aide à comprendre pourquoi l’événement est traité comme une “plus grande fuite” de ce type. Le volume de 500 Go ne représente pas un simple snapshot. Il dessine un système vivant, avec son outillage, ses contraintes matérielles et ses arbitrages. Et c’est précisément cette continuité qui met la Grande Muraille de Chine numérique en péril sur le plan technique.

Après l’autopsie de la fuite, le sujet se déplace naturellement vers ce que l’archive raconte des capacités concrètes, notamment autour du DPI et de la détection des VPN.

Du code source aux capacités DPI : VPN, empreintes TLS et journalisation de session

Les documents décrivent un ensemble orienté vers l’analyse fine du trafic, avec un accent sur la détection des VPN et l’identification de comportements de contournement. Il ne s’agit pas seulement de bloquer une adresse IP. Au contraire, l’objectif consiste à reconnaître des patterns : négociation TLS, caractéristiques de paquets, ou signatures d’outils connus. C’est là que la cybersécurité rencontre la standardisation industrielle, car les mêmes techniques servent aussi à la lutte anti-fraude, à l’optimisation réseau, ou à la conformité.

Un point ressort : l’usage d’empreintes SSL/TLS, souvent via des “fingerprints” observables, pour distinguer des clients légitimes de bibliothèques automatisées. Ensuite, des modules semblent viser le throttling, c’est-à-dire la dégradation sélective, plutôt que le blocage frontal. Pourquoi dégrader ? Parce que cela réduit la visibilité politique et complique le diagnostic côté utilisateur. Résultat : un service paraît “lent” au lieu d’être “interdit”.

Détection des VPN : entre signatures et heuristiques

Sur le terrain, la détection VPN combine deux familles de méthodes. D’abord, la signature : un protocole laisse des traces, comme une séquence de handshake. Ensuite, l’heuristique : longueur des paquets, timing, ou distribution des ports. Les documents divulgués décrivent des briques qui semblent assembler ces signaux. Ainsi, un outil de censure peut marquer un flux “suspect” et l’envoyer vers une politique de filtrage plus agressive.

Pour le grand public, cela se traduit par un paradoxe. Un VPN “bien connu” peut être bloqué plus vite qu’une solution confidentielle. Toutefois, une solution confidentielle peut tomber si elle reprend une bibliothèque TLS standard. C’est pourquoi les outils de contournement modernes investissent dans l’obfuscation, ou dans des transports qui imitent du HTTPS banal.

Journalisation complète et risques d’espionnage

La fuite mentionne des mécanismes proches de la journalisation de session, parfois jusqu’au suivi “full-session”. Techniquement, cela implique une capacité de corrélation élevée, donc des buffers, des index, et des politiques de rétention. Même sans contenu déchiffré, des métadonnées peuvent suffire à cartographier des relations. Par conséquent, le risque d’espionnage ne dépend pas uniquement de l’interception du texte. Il dépend aussi de la reconstitution d’activités et d’habitudes.

En parallèle, les documents évoquent aussi l’interception d’HTTP non chiffré. Ce point est moins spectaculaire en 2026, car une grande partie du Web est passée en HTTPS. Néanmoins, certains objets connectés, portails captifs, ou services legacy exposent encore des requêtes en clair. Dès lors, un système DPI peut capturer des identifiants faibles, ou des URL sensibles, ce qui élargit la surface d’abus.

Liste de vérifications pour analyser une archive sensible sans se mettre en danger

Le téléchargement d’une archive liée à un système de censure n’est pas anodin. D’un côté, elle peut contenir des malwares opportunistes greffés après la fuite. De l’autre, elle peut exposer des éléments illégaux selon les juridictions. Pour rester pragmatique, voici une liste de précautions courantes en cybersécurité :

- Isoler l’analyse dans une VM sans accès aux comptes personnels, idéalement sur une machine dédiée.

- Couper le réseau ou basculer en mode “air-gapped” pour l’extraction et l’indexation initiales.

- Calculer des hashes (SHA-256) et comparer avec des références publiques quand elles existent.

- Ouvrir les documents dans des viewers durcis, et éviter les macros.

- Journaliser les actions de l’environnement d’analyse pour retracer toute exécution inattendue.

Ces mesures ne règlent pas tout. Cependant, elles réduisent fortement le risque opérationnel, ce qui permet ensuite de discuter des implications matérielles et industrielles exposées par la fuite.

Les capacités logicielles racontent une histoire, mais les plateformes matérielles en racontent une autre. Le fil suivant concerne donc les serveurs, l’intégration opérateur et la bascule vers du hardware local.

Matériel, datacenters et “censure en boîte” : serveurs, performances et industrialisation

Les archives décrivent une plateforme présentée comme un produit commercial prêt à déployer, parfois surnommé “pare-feu en boîte”. Cette approche change l’échelle. Au lieu d’un assemblage artisanal, un opérateur reçoit un kit : appliances, scripts, métriques et procédures. En conséquence, la barrière d’entrée baisse, ce qui facilite la vente d’un outil de censure à l’étranger. Pour le secteur hardware, cela signifie surtout une standardisation des architectures : x86, accélération réseau, et stockage rapide pour les logs.

Un détail ressort : les premiers déploiements auraient utilisé des serveurs de marques internationales, avant une transition vers des composants d’origine chinoise sous pression de sanctions et de contrôles export. Ce type de migration se voit aussi dans d’autres domaines, comme les GPU pour IA. Néanmoins, pour le DPI, le goulot d’étranglement n’est pas toujours le calcul brut. Il se situe souvent sur l’I/O : cartes réseau, offload, et latence mémoire lors de la classification de flux.

Cas d’école : un déploiement à grande échelle et ses métriques

Une feuille de déploiement évoque une mise en place dans plusieurs dizaines de datacenters, avec des tableaux de bord capables de suivre des dizaines de millions de connexions TCP simultanées. Cette granularité a un coût. D’abord, il faut maintenir des états de connexion. Ensuite, il faut distribuer la charge sur plusieurs nœuds, tout en gardant une cohérence de décision. Enfin, il faut superviser des règles qui évoluent vite, car les outils de contournement s’adaptent.

Pour rendre cela concret, imaginons l’opérateur fictif “Lotus IX”, qui doit filtrer un échange national. Si le système suit 80 millions de connexions, il doit dimensionner la RAM, le bus PCIe, et la capacité de capture. De plus, il doit prévoir le stockage des logs, même si une partie est échantillonnée. Dès lors, la fuite intéresse aussi les ingénieurs système, car elle dévoile des choix d’architecture reproductibles.

Comparaison pragmatique des approches matérielles DPI (sans marque dogmatique)

Deux modèles dominent dans l’industrie. D’un côté, des appliances spécialisées, parfois avec FPGA ou ASIC. De l’autre, des clusters x86 avec accélération via SmartNIC et DPDK. Le premier modèle offre une latence stable, mais il coûte cher et se met à jour plus lentement. Le second modèle évolue plus vite, mais il exige une forte discipline DevOps. Dans les documents divulgués, l’approche semble fortement orientée “datacenter”, donc plus proche du modèle cluster.

Cette orientation a une conséquence directe : la fuite en ligne de scripts et de runbooks peut donner des indices sur l’automatisation, donc sur les points d’appui. Par exemple, des pipelines de déploiement révèlent parfois des endpoints internes, des conventions de secrets, ou des dépendances non patchées. C’est pourquoi, même sans vulnérabilité “0-day”, l’archive peut nourrir des attaques opportunistes.

Une fois la couche matérielle clarifiée, la question la plus politique revient : comment ce type de plateforme se retrouve exporté, et que signifie la vente à plusieurs États pour l’écosystème mondial ?

Vente à l’étranger : l’outil de censure vendu à trois pays et l’effet domino

La fuite et les enquêtes associées éclairent une dimension commerciale : l’export de briques DPI et de filtrage vers d’autres gouvernements. Les informations disponibles citent au moins trois pays comme bénéficiaires ou intégrateurs, avec des variantes selon les sources : Myanmar, Pakistan, Éthiopie, Kazakhstan. Ce panorama ne surprend plus les spécialistes, car le marché de l’interception légale et des passerelles de filtrage est ancien. Toutefois, l’intérêt ici tient au niveau de détail : architecture interne, métriques, et logique de déploiement.

La vente d’un outil de censure n’est pas une simple transaction de boîtiers. Elle inclut souvent l’intégration avec des systèmes d’interception, des plateformes de collecte, et des consoles d’analytique. Par conséquent, les frontières entre “censure”, “cybersécurité” et “surveillance” deviennent poreuses. Un État peut justifier l’achat par la lutte contre la criminalité. Cependant, l’usage peut glisser vers le contrôle politique, surtout lorsque la classification se fait à l’échelle des points d’échange.

Myanmar : filtrage à l’échelle des échanges et supervision massive

Les documents évoquent un déploiement étendu sur plusieurs dizaines de datacenters, avec un suivi de connexions simultanées à un niveau rarement public. Techniquement, cela implique une insertion proche du cœur du réseau, donc une capacité à bloquer en masse ou à filtrer finement. Cette proximité du backbone rend aussi le système résilient, car il ne dépend pas de quelques routeurs périphériques.

Sur le plan humain, l’impact est immédiat : médias inaccessibles, messageries instables, ou ralentissements sélectifs pendant des événements. Et comme le throttling ressemble à une panne, le diagnostic devient un parcours du combattant. Cette ambiguïté sert souvent la stratégie de contrôle, car elle limite la preuve directe.

Pakistan et WMS 2.0 : quand la censure croise la surveillance mobile

Des éléments de presse décrivent une intégration possible dans un système plus large, parfois nommé WMS 2.0, avec des capacités de surveillance en temps réel des réseaux mobiles. La nuance est importante : sur mobile, l’identifiant d’abonné, la localisation approximative et les métadonnées s’agrègent facilement. Ainsi, un pipeline DPI peut alimenter des tableaux de bord décisionnels, et accélérer des actions de blocage.

Pour la cybersécurité, cela pose aussi un risque secondaire : si l’infrastructure est compromise, elle devient une sonde d’espionnage idéale. Un attaquant qui contrôle un point de collecte n’a plus besoin d’implanter des milliers de terminaux. Il écoute au bon endroit, au bon moment.

Ce que la fuite change pour les journalistes, ONG et DSI

Pour les journalistes d’investigation et les ONG, la fuite apporte des éléments techniques vérifiables. Les débats gagnent en précision : on peut parler de modules, de signatures, et de procédures, plutôt que d’intentions vagues. Pour les DSI d’entreprises opérant dans ces zones, l’enjeu est pratique : segmentation, chiffrement bout en bout, et discipline de mise à jour deviennent non négociables.

En filigrane, la question suivante se pose : si l’on connaît mieux la machine, peut-on mieux la contourner, ou au contraire facilite-t-on sa reproduction ? Ce dilemme ouvre naturellement sur les impacts en sécurité offensive et défensive.

Une fuite de cette ampleur n’est pas qu’un scandale. Elle devient aussi un corpus d’étude, avec des effets potentiels sur la recherche en contournement et sur les attaques ciblant les infrastructures.

Conséquences en cybersécurité : contournement, failles opérationnelles et risques d’espionnage

Une archive de 500 Go agit comme un accélérateur. D’abord, elle aide les chercheurs à comprendre les mécanismes de détection. Ensuite, elle peut exposer des erreurs de conception : gestion de mémoire, parsing fragile, ou dépendances non maintenues. Enfin, elle révèle des pratiques d’exploitation qui se répètent sur plusieurs sites. Par conséquent, le péril concerne autant la robustesse que la réputation.

Il faut aussi distinguer deux usages. Le premier est défensif : améliorer les outils de contournement et protéger des populations. Le second est offensif : exploiter la connaissance pour attaquer des passerelles, détourner des flux, ou fabriquer des implants plus discrets. Dans les deux cas, le facteur temps compte. Plus l’archive circule, plus la probabilité d’un usage malveillant augmente.

Faiblesses “protocole” versus erreurs d’exploitation

Les failles protocolaires sont rares et coûteuses à trouver. À l’inverse, les erreurs d’exploitation sont fréquentes : certificats expirés, ports d’administration exposés, ou mots de passe par défaut oubliés lors d’un déploiement en urgence. Or, une fuite qui contient des notes de dev et des logs peut guider vers ces erreurs. C’est moins glamour qu’un exploit kernel, mais souvent plus efficace.

Un exemple typique : une console de monitoring accessible depuis un VLAN mal segmenté. Si un runbook mentionne une URL interne récurrente, un attaquant sait quoi scanner après un pivot. De même, une convention de nommage peut révéler l’existence d’environnements de test. Et un environnement de test, par définition, est moins durci.

Impact sur les outils de contournement : pourquoi le détail compte

Les équipes qui développent des solutions anti-censure cherchent des signaux minimaux. Si l’archive mentionne des critères de détection précis, elles peuvent ajuster leurs transports. Par exemple, si la classification se base sur un fingerprint TLS, un client peut randomiser certains champs. En revanche, si la plateforme corrèle aussi le timing et le comportement applicatif, l’obfuscation doit être plus profonde. Cette bataille ressemble à une course, et la fuite fournit un plan de la piste.

Dans un registre plus concret, les entreprises peuvent aussi en tirer des leçons. Beaucoup d’organisations déploient des boîtiers DPI légitimes pour la sécurité. Or, les mêmes risques s’appliquent : fuite de runbooks, exposition de dashboards, et collecte excessive de logs. Ainsi, la prudence n’est pas réservée aux États.

Bonnes pratiques immédiates pour limiter l’exploitation d’une fuite de code source

Lorsqu’un code source critique fuit, le réflexe n’est pas seulement juridique. Il faut agir sur l’attaque probable. Quelques actions concrètes s’imposent souvent, même en dehors du contexte étatique :

- Rotation des secrets : clés API, certificats, mots de passe de service, et tokens CI/CD.

- Audit des interfaces d’administration : exposition, MFA, durcissement et journalisation.

- Réduction des privilèges : comptes de service et segmentation réseau plus stricte.

- Chasse aux IOC : surveiller des scans ciblant les ports ou endpoints mentionnés dans la doc.

- Plan de communication : informer les partenaires techniques pour éviter l’effet domino.

Ces mesures n’effacent pas la fuite. En revanche, elles réduisent le bénéfice opérationnel pour un acteur hostile, ce qui reste l’objectif pragmatique.

Pourquoi cette fuite en ligne de 500 Go est-elle considérée comme exceptionnelle ?

Parce qu’elle rassemble à la fois du code source, des documents confidentiels, des journaux opérationnels et des guides de déploiement. Ce mélange décrit un système complet, depuis la construction logicielle jusqu’à l’exploitation en production, ce qui augmente la valeur technique pour l’audit comme pour l’attaque.

Que révèle la fuite sur l’outil de censure et sa vente à trois pays ?

Les éléments disponibles décrivent une plateforme de filtrage industrialisée, pensée pour être déployée chez des opérateurs. Des rapports publics associés évoquent l’exportation de briques DPI vers plusieurs États, avec au moins trois pays régulièrement cités dans les investigations, ce qui montre une logique de produit et de marché, pas seulement un usage domestique.

Quels sont les risques concrets en cybersécurité et en espionnage pour les utilisateurs ?

Le risque principal vient de la corrélation et des métadonnées : qui communique, quand, et avec quels services. Même sans déchiffrement, un système DPI peut profiler des comportements. De plus, si des interfaces d’administration ou des pratiques d’exploitation sont exposées, une compromission de l’infrastructure peut transformer la plateforme en outil d’espionnage à grande échelle.

Que doivent faire les équipes techniques face à une fuite de code source critique ?

Priorité à la rotation des secrets, à l’audit des surfaces d’administration, et à la segmentation réseau. Ensuite, il faut surveiller les tentatives d’exploitation liées aux endpoints ou dépendances mentionnés dans les documents. Enfin, un plan de coordination avec les partenaires réduit l’effet domino sur l’écosystème.