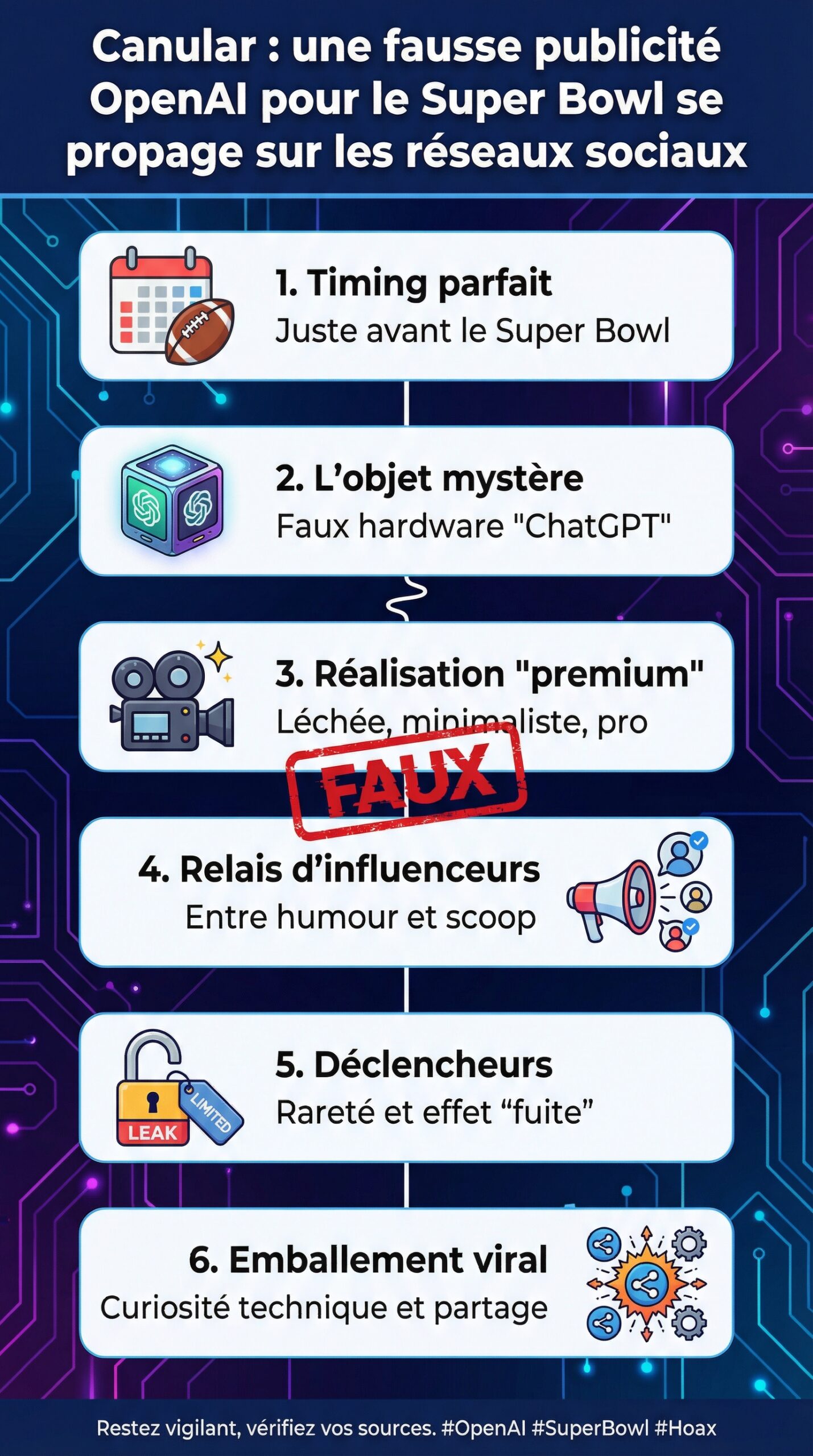

À quelques jours du Super Bowl, une vidéo présentée comme une fausse publicité d’OpenAI a inondé les réseaux sociaux avec une efficacité déroutante. Le clip semblait cocher toutes les cases d’un lancement « premium » : une réalisation léchée, un storytelling minimaliste, et surtout un objet mystérieux présenté comme un nouveau hardware lié à ChatGPT. Dans la foulée, des comptes influents ont relayé le contenu, parfois avec un ton de humour, parfois avec l’assurance d’un scoop. Résultat : un emballement viral typique, où la curiosité technique s’est mêlée à la course au partage.

Ce qui frappe, pourtant, n’est pas seulement la qualité de la vidéo. C’est la mécanique de désinformation qu’elle révèle, entre fake news et manipulation d’audience. Le Super Bowl reste un aimant à rumeurs, car l’événement est associé à des annonces spectaculaires et à des budgets publicitaires hors norme. Dans ce contexte, l’idée d’un spot OpenAI « annulé à la dernière minute » a servi de carburant narratif. Ensuite, la rumeur s’est structurée : un nom de produit, des visages connus, une promesse de rupture. Autrement dit, un canular pensé comme un vrai lancement, et donc crédible à première vue.

En Bref

- Une vidéo de canular imitant une publicité OpenAI liée au Super Bowl s’est propagée de façon virale sur les réseaux sociaux.

- Le clip a exploité les codes du lancement hardware et un récit de « fuite » pour amplifier la désinformation et la manipulation.

- Des signaux techniques (montage, métadonnées, incohérences de production) aident à distinguer une fake news d’un contenu officiel.

Canular OpenAI au Super Bowl : comment une fausse publicité devient virale

Une rumeur ne se propage pas au hasard, et ce canular l’illustre avec méthode. D’abord, le Super Bowl joue le rôle de « caisse de résonance », car les marques y déploient des campagnes très scénarisées. Ensuite, OpenAI occupe un espace mental déjà saturé d’attentes : nouveaux modèles, partenariats, et surtout spéculations sur un futur appareil grand public. Ainsi, une fausse publicité calée sur ce calendrier bénéficie d’un contexte prêt à l’emploi.

Dans la pratique, la propagation a suivi un schéma classique. Au départ, la vidéo circule sur un petit réseau de comptes spécialisés. Puis, elle bascule vers des agrégateurs d’actualité tech et des pages « curiosités IA ». Enfin, les rediffusions arrivent sur des plateformes à forte friction sociale, où le partage sert aussi de signal d’appartenance. Pourquoi résister à une vidéo « leakée » quand tout le monde la commente déjà ?

Un élément a accéléré la dynamique : le clip ne ressemblait pas à un montage amateur. Au contraire, il adoptait les codes des grandes publicités, avec plans serrés, musique sobre et slogans courts. Par conséquent, beaucoup ont confondu « qualité visuelle » et « authenticité ». Pourtant, un contenu bien produit peut être faux, surtout quand les outils de création assistée ont abaissé la barrière d’entrée.

Les déclencheurs psychologiques : rareté, exclusivité, et effet “leak”

Le récit du « spot annulé » est un classique, car il crée une rareté artificielle. De plus, il valorise le spectateur : celui qui regarde a l’impression d’accéder à une information réservée. Ensuite, l’émotion prend le dessus sur la vérification, surtout si le sujet touche une marque très commentée. Dans ce cas précis, le mot « hardware » a agi comme un aimant, car le grand public imagine facilement une nouvelle catégorie de produit.

Pour rendre la fuite crédible, le clip utilisait aussi un vocabulaire minimaliste, presque institutionnel. Cette sobriété évite les erreurs grossières, et donc limite les alertes. En parallèle, les commentaires reprenaient la rumeur avec un ton mi-sérieux mi-ironique, ce qui protège le partage : « si c’est faux, c’est juste pour rire ». Ce double jeu favorise la circulation.

Étude de cas : un fil conducteur côté terrain

Dans une rédaction tech, un scénario revient souvent. Un lecteur, appelons-le Marc, envoie un lien « urgent » via un formulaire anonyme, car il a vu la vidéo passer sur plusieurs comptes. Ensuite, il demande si l’appareil est réel, et si une fiche technique existe. Or, ce type de sollicitation montre l’impact concret de la désinformation : elle crée du support, de la recherche, et de l’anxiété de manquer une annonce.

Une fois l’attention captée, la discussion glisse vite vers le “qui a raison” plutôt que vers “quels sont les faits”. C’est précisément ce déplacement qui fait durer l’emballement. L’insight à retenir est simple : plus une histoire semble “dans l’air du temps”, plus elle se partage sans preuve.

Après la mécanique de viralité, l’étape logique consiste à examiner ce que le clip prétend montrer, et pourquoi la promesse hardware a autant accroché.

Fausse publicité OpenAI et hardware “ChatGPT” : pourquoi le récit du nouvel appareil séduit

Le cœur du canular repose sur une promesse : OpenAI préparerait un appareil dédié, parfois présenté sous un nom court et mémorisable, comme “Dime”. Ce type de branding est efficace, car il évoque un objet compact, grand public, et presque “évident”. Ensuite, l’histoire se renforce avec des ingrédients familiers : une star associée au clip, un design supposé “révolutionnaire”, et une collaboration attribuée à un designer iconique. Même sans preuve, l’ensemble paraît plausible.

Pourtant, une annonce hardware crédible ne se limite pas à une vidéo. En général, elle s’accompagne d’un minimum de traces : dépôts réglementaires, partenaires industriels, signaux logistiques, ou au moins une cohérence de messages. Ici, la vidéo proposait un appareil sans expliquer l’usage réel, ce qui est paradoxal. En effet, un objet “IA” a besoin d’un contexte : micro, caméra, autonomie, connectivité, et politique de confidentialité. Sans ces éléments, la promesse reste une coquille marketing.

Le canular a aussi joué sur une confusion fréquente : l’idée qu’un modèle d’IA doit forcément avoir “son” matériel. Or, l’IA moderne fonctionne très bien via smartphone, PC, ou cloud. Certes, un appareil dédié peut exister, mais il doit apporter un avantage clair : latence plus faible, traitement local, ou intégration domotique. Sans bénéfice concret, l’objet ressemble à un prétexte narratif, ce qui est typique d’une fake news bien emballée.

Ce que dirait une vraie fiche produit (et ce que le canular évite)

Une publicité officielle, surtout autour du Super Bowl, pousse généralement vers un site, une précommande, ou une démonstration. Ici, l’absence d’appel à l’action cohérent est un signal. De plus, les mentions légales, pourtant banales dans les campagnes premium, manquaient ou semblaient génériques. Enfin, le clip ne clarifiait pas la relation entre l’objet et ChatGPT : simple télécommande ? assistant vocal ? terminal sécurisé ?

Pour aider à raisonner, voici une liste d’indices qu’un lancement hardware sérieux laisserait presque toujours :

- Un positionnement d’usage clair : maison, mobilité, bureau, santé, ou voiture.

- Des contraintes techniques assumées : autonomie, connectivité, capteurs, stockage.

- Un écosystème explicite : applications, API, compatibilité, mises à jour.

- Une chaîne de confiance : politique de données, chiffrement, traitements locaux.

- Des partenaires visibles : fabrication, distribution, SAV, certifications.

Un canular, au contraire, reste volontairement flou. Ce flou permet à chacun d’imaginer “son” produit idéal, et donc d’y croire plus facilement. L’insight final est net : plus un objet est mystérieux, plus il est simple à vendre… même quand il n’existe pas.

Le Super Bowl comme amplificateur d’illusion technologique

Le Super Bowl est aussi un théâtre d’innovation perçue. Certaines années, la soirée a été saturée de messages “IA”, au point de créer une fatigue chez une partie du public. Dans ce bruit ambiant, un faux spot OpenAI se fond facilement dans le décor. Par ailleurs, la concurrence entre acteurs de l’IA, y compris via des publicités agressives, rend le récit d’une “riposte” plausible. L’imaginaire collectif fait le reste.

La suite logique consiste donc à quitter le récit marketing, et à passer aux méthodes de vérification. C’est là que l’analyse technique devient utile, même pour le grand public.

Une fois la promesse dégonflée, il reste à comprendre comment démonter proprement ce type de vidéo, sans tomber dans la surenchère.

Désinformation et manipulation : les techniques pour authentifier une vidéo virale sur les réseaux sociaux

Face à une vidéo virale, la première réaction devrait être l’économie d’effort : vérifier vite, avant de commenter. Pourtant, les réseaux sociaux récompensent l’inverse, car le commentaire rapide génère de la visibilité. C’est ainsi que la désinformation s’installe. Heureusement, quelques réflexes simples suffisent pour faire baisser le risque, sans devenir analyste forensic.

La méthode la plus efficace commence par la source. Un compte récent, un pseudo changeant, ou une biographie vide ne prouvent rien, mais ils augmentent le doute. Ensuite, il faut chercher la “première mise en ligne” : un repost n’a aucune valeur probante. Enfin, un contenu officiel laisse presque toujours une trace sur des canaux maîtrisés, même si la diffusion TV n’a pas eu lieu.

Contrôles techniques rapides : audio, montage, et cohérence visuelle

Un canular haut de gamme évite les défauts évidents, cependant il laisse des signatures. D’abord, l’audio : des variations de timbre, une réverbération incohérente, ou un mixage “trop propre” peuvent trahir une synthèse. Ensuite, le montage : les coupes rapides masquent souvent des artefacts de génération. Enfin, la cohérence visuelle compte : reflets, mouvements de mains, et textes à l’écran sont des zones à risque.

Un exemple concret : une séquence qui montre un appareil, mais n’affiche jamais d’interface nette, peut être volontairement évasive. De même, un logo qui n’apparaît qu’une fraction de seconde ressemble à une astuce pour éviter l’examen. Ces détails ne suffisent pas seuls, toutefois ils orientent l’enquête.

Métadonnées, empreintes et recherche inversée

Quand un fichier circule en téléchargement direct, les métadonnées peuvent aider. Souvent, elles sont effacées, mais l’absence totale d’informations sur un contenu “censé fuiter d’une régie TV” pose question. Ensuite, la recherche inversée d’images, même approximative, permet de repérer des plans issus de banques vidéo. Par ailleurs, une vérification des polices de caractères peut révéler un habillage non standard.

Dans un cadre éditorial, une routine simple fonctionne bien : comparer le style avec des publicités confirmées, puis vérifier l’existence de pages officielles liées. Si rien n’existe, la probabilité de fake news grimpe rapidement. L’insight à garder est pragmatique : l’authenticité se prouve, alors que la rumeur se raconte.

Le rôle du humour dans la propagation de la fake news

Le humour sert souvent de bouclier social. Une personne partage “pour rire”, et pourtant elle contribue à l’audience. Ensuite, d’autres reprennent le contenu sans la distance initiale. Ce glissement transforme une blague en information supposée. Par conséquent, il devient utile d’ajouter un contexte lors d’un partage, ou de s’abstenir si la source reste floue.

À ce stade, une question se pose : pourquoi des canulars “hardware” reviennent-ils si souvent ? La réponse touche autant à la technologie qu’à l’économie de l’attention.

Après l’authentification, il reste à analyser le marché : l’IA grand public attire les budgets, et la publicité du Super Bowl en devient un miroir.

Publicités IA au Super Bowl : tendances 2026, rivalités et appétit pour le hardware

Le Super Bowl est devenu un baromètre publicitaire. Quand une technologie prend de l’ampleur, elle s’y affiche, parfois jusqu’à l’excès. Ces dernières saisons, l’IA a occupé une place visible, avec des messages orientés “assistant”, “créativité” ou “productivité”. Cependant, une partie du public reste sceptique, car les promesses se ressemblent. Dans ce paysage, une fausse publicité OpenAI se greffe facilement, car elle semble “dans la tendance”.

La rivalité entre laboratoires d’IA ajoute un autre étage. Certaines campagnes ont choisi la provocation, en critiquant l’intégration de contenus sponsorisés ou la dérive vers le placement de produits dans les assistants. Ce climat nourrit la spéculation : si un acteur attaque, l’autre répondra, pense-t-on. Ainsi, la rumeur d’un spot “surprise” paraît cohérente, même sans annonce officielle.

Pourquoi le hardware IA fascine encore, malgré les échecs passés

Le hardware dédié fascine, car il promet une interaction plus naturelle que le smartphone. De plus, il suggère une relation continue avec l’assistant, donc une valeur perçue plus forte. Pourtant, l’histoire récente rappelle que l’objet doit résoudre un problème concret. Sans cela, il rejoint la catégorie des gadgets. Les consommateurs retiennent les ratés, et ils demandent désormais des preuves d’utilité.

Dans ce contexte, un canular peut servir de “test social” involontaire. En effet, les réactions montrent ce que le public veut vraiment : un mode hors ligne, une meilleure confidentialité, ou un assistant qui comprend le contexte. Les commentaires deviennent alors une étude de marché gratuite, même si la rumeur est toxique.

Comparaison pragmatique : smartphone, PC et appareil dédié

Pour clarifier, il faut comparer les options, car elles coexistent déjà. Le smartphone offre capteurs, batterie, et réseau. Le PC apporte confort et puissance locale, surtout avec des NPU modernes. Un appareil dédié, lui, doit justifier son existence par une spécialisation : micro longue portée, dock domestique, ou intégration voiture. Sinon, il ajoute une contrainte de recharge et de maintenance.

Le point clé est économique : un spot du Super Bowl coûte cher, donc une marque y pousse rarement un produit incertain. Un “leak” qui prétend l’inverse doit donc être challengé. L’insight final tient en une phrase : plus l’histoire semble coûteuse, plus elle doit être documentée.

Reste un dernier volet, souvent négligé : les effets sur la sécurité, l’image de marque, et les lecteurs qui veulent s’informer sans se faire piéger.

Avant les questions pratiques, il est utile d’identifier les impacts concrets et les bons réflexes pour éviter de servir de relais involontaire à une manipulation.

Impact du canular OpenAI : sécurité, confiance et bonnes pratiques face aux fake news

Une fake news n’est pas seulement une erreur d’information. Elle peut déclencher des conséquences mesurables : usurpation de marque, phishing, ou collecte de données via de faux sites de précommande. Dans le cas d’une fausse publicité OpenAI, le risque typique est la création de pages imitant une boutique, avec inscription à une liste d’attente. Ensuite, des utilisateurs saisissent email et numéro, et l’escroquerie commence. Ce scénario a déjà été observé avec d’autres produits “leakés”.

La confiance est aussi touchée. Quand un public se fait piéger, il devient plus méfiant envers les annonces réelles. À long terme, cela pénalise les acteurs sérieux. Par ailleurs, les journalistes et créateurs de contenu perdent du temps à démentir au lieu d’analyser des produits tangibles. Ce coût d’opportunité est rarement visible, mais il est bien réel.

Hygiène numérique : gestes simples qui bloquent la manipulation

Quelques pratiques réduisent fortement l’exposition. D’abord, ne pas cliquer sur un lien “précommande” sans domaine officiel vérifié. Ensuite, éviter de télécharger un fichier vidéo depuis une source inconnue, car certains pièges exploitent des lecteurs vulnérables. Enfin, activer l’authentification à deux facteurs sur les comptes sociaux limite les prises de contrôle, souvent utilisées pour amplifier un contenu viral.

Pour les lecteurs qui partagent, une règle aide : ajouter un contexte. Par exemple, “vidéo non confirmée” ou “source incertaine” réduit la confusion. Cela paraît banal, pourtant ce simple ajout coupe l’effet de certitude, et donc la désinformation.

Ce qu’une entreprise fait en général pour contrer une fausse publicité

Quand une marque est visée, elle privilégie des démentis rapides et traçables. Un message court sur un canal officiel, puis une demande de retrait sur les plateformes, sont des actions classiques. Ensuite, des porte-parole peuvent confirmer l’inauthenticité auprès des médias. Dans cette affaire, des responsables d’OpenAI ont publiquement contesté la véracité du “leak”, ce qui a aidé à calmer une partie du bruit. Néanmoins, le démenti n’atteint pas toujours les mêmes audiences que la rumeur.

Il faut aussi compter avec l’effet Streisand : trop insister peut relancer la curiosité. Une réponse efficace reste factuelle, sobre, et orientée vers des preuves. L’insight final est opérationnel : un bon démenti ne se bat pas contre l’émotion, il rétablit une chronologie vérifiable.

Les questions qui reviennent le plus portent désormais sur la détection, la responsabilité et les réflexes de partage. Elles méritent des réponses directes.

Quels indices permettent d’identifier rapidement une fausse publicité OpenAI liée au Super Bowl ?

Vérifier la source d’origine, chercher une publication sur les canaux officiels d’OpenAI, et repérer l’absence d’appel à l’action cohérent (site, précommande, mentions légales). Ensuite, contrôler la cohérence audio/vidéo (coupes qui masquent l’objet, logo furtif, interface jamais lisible) aide à suspecter un canular.

Pourquoi ce type de canular devient-il si viral sur les réseaux sociaux ?

Parce qu’il combine rareté (fuite), prestige (Super Bowl), et promesse technologique (hardware IA). De plus, le partage “pour humour” sert souvent de prétexte, tout en amplifiant la portée. Enfin, l’algorithme valorise l’engagement, pas la vérification.

Le récit d’un appareil ChatGPT dédié est-il plausible malgré tout ?

Un appareil dédié est plausible si l’usage est clair et si l’avantage est mesurable (latence réduite, traitement local, confidentialité, intégration domotique). Toutefois, une vraie annonce laisse des traces : partenaires industriels, pages officielles, et messages cohérents. Un clip sans détails techniques reste typique d’une fake news.

Comment éviter de participer à la désinformation en partageant une vidéo non confirmée ?

Ne pas relayer sans contexte, mentionner explicitement que la source n’est pas confirmée, et privilégier un lien vers un démenti ou une vérification. Par ailleurs, éviter les liens de “précommande” non officiels réduit les risques de manipulation et d’arnaque.