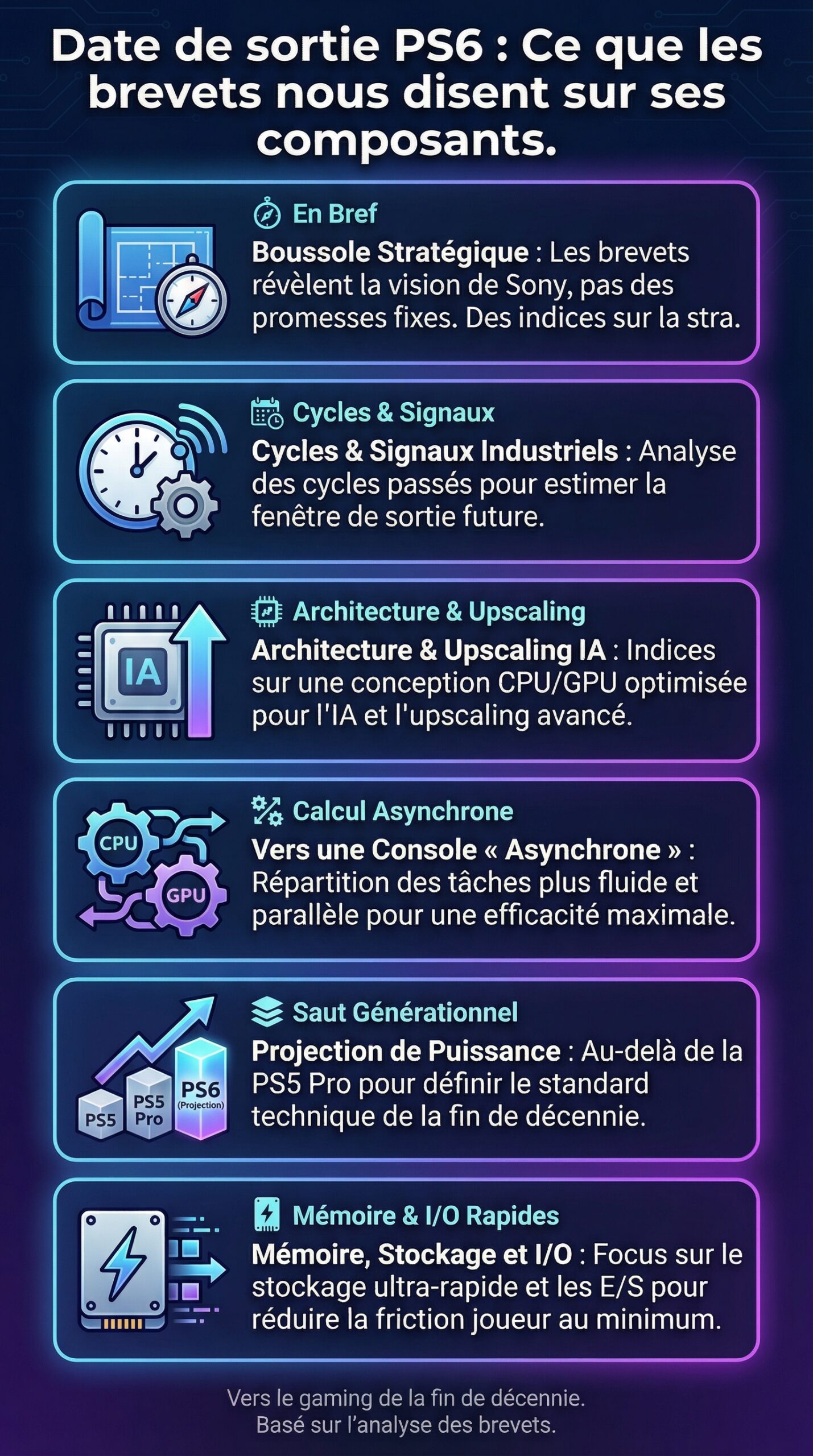

À chaque génération, la même mécanique se répète : avant même qu’une console de jeu soit officiellement présentée, l’écosystème des brevets et des dépôts techniques commence à dessiner une silhouette. Pour la PS6, les indices sont plus subtils qu’un simple “nouveau design”. Ils parlent de hardware, de méthodes de calcul, de gestion énergétique, de compatibilité, et surtout d’axes de technologie qui visent à réduire la friction côté joueur. Or, si un brevet n’est jamais une promesse de produit, il sert souvent de boussole : il révèle ce que Sony juge stratégique, ce que les ingénieurs protègent, et ce qui pourrait faire la différence dans le gaming de la fin de décennie.

La question de la date de sortie n’est donc pas qu’un jeu de spéculation. Elle se comprend aussi via le tempo industriel : cycles de gravure, maturité des stacks logiciel, disponibilité mémoire, et coût des composants. En croisant les signaux faibles des brevets avec les réalités du marché, il devient possible d’identifier les paris plausibles : une console plus “assistée” par l’IA, une stratégie d’upscaling plus agressive, une architecture mémoire plus flexible, et une attention renforcée à la dissipation thermique. La suite explore ces pièces du puzzle, en gardant un fil conducteur concret : le cas d’un studio fictif, Atelier Meridian, qui prépare un jeu d’action en monde ouvert et anticipe déjà les contraintes et opportunités d’une future plateforme.

En Bref

- Les brevets liés à l’affichage, à la mémoire et à l’efficacité énergétique orientent les hypothèses sur les composants de la PS6.

- La date de sortie dépend autant des choix de hardware (nœud de gravure, coût, rendement) que de la stratégie de Sony pour le gaming cross-gen.

- L’innovation attendue se concentre sur l’upscaling, la latence, la gestion thermique et une architecture plus “systémique” pour les mondes ouverts.

Date de sortie PS6 : lecture des cycles Sony et signaux industriels

La date de sortie d’une console se lit d’abord dans la cadence historique des plateformes. Cependant, il faut aussi regarder l’amont : disponibilité des wafers, maturité des outils de développement, et capacité à sécuriser des volumes de composants sans exploser le prix public. Ainsi, même si les cycles passés donnent une fourchette, l’équation 2026-2028 est surtout dictée par la transition technologique : le saut de performance n’est acceptable que si le coût par frame baisse réellement.

Ensuite, les brevets jouent un rôle indirect sur le calendrier. Quand Sony dépose des idées autour de la réduction de latence, de la compression, ou du scheduling des tâches GPU, cela suggère un chantier logiciel lourd. Or, un chantier lourd implique des SDK plus complexes, donc un temps de stabilisation plus long. À l’inverse, des dépôts sur des solutions de packaging thermique ou de gestion de puissance indiquent souvent une préparation à l’industrialisation, ce qui rapproche la fenêtre de lancement.

Dans le cas d’Atelier Meridian, le directeur technique doit figer un “target” matériel au moins deux ans avant la sortie. Pourtant, l’équipe sait qu’une nouvelle console de jeu provoque une période de transition. Par conséquent, le studio maintient un mode “scalable” : textures adaptatives, densité de foule variable, et budgets CPU paramétrables. Cette approche devient rationnelle si la PS6 arrive avec une stratégie cross-gen prolongée, comme ce fut le cas sur plusieurs périodes du marché.

De plus, les tendances de l’industrie en 2025-2026 pèsent sur la fenêtre. Les fabricants cherchent un meilleur rendement énergétique, car la contrainte thermique limite désormais les gains bruts. Ainsi, une innovation majeure peut être “moins de watts pour plus d’images”, plutôt que “deux fois plus de TFLOPS”. En conséquence, une date plausible serait celle où un nœud de gravure et une mémoire rapide atteignent un coût stable, ce qui réduit le risque de pénurie au lancement.

Enfin, il faut relier la sortie à l’écosystème logiciel. Quand l’outillage de profiling, le support des moteurs (Unreal, Unity, moteurs propriétaires), et les bibliothèques d’upscaling sont prêts, la bascule devient crédible. En pratique, le marché attend un saut visuel net sur les mondes ouverts, donc la date de sortie sera alignée sur la capacité à livrer des vitrines techniques. Ce point devient la vraie boussole du planning.

Brevets PS6 : ce qu’ils suggèrent sur l’architecture CPU/GPU et l’upscaling

Les brevets liés aux pipelines de rendu sont souvent les plus parlants, car ils ciblent des “goulots” connus : reconstruction d’image, anti-aliasing, et réduction de bruit. Ainsi, si des dépôts décrivent des méthodes d’inférence embarquée pour améliorer la résolution perçue, ils cadrent bien avec une stratégie d’upscaling évoluée. Cela ne garantit pas un module dédié, mais cela indique que Sony veut verrouiller une approche, que ce soit via le GPU, un bloc d’accélération, ou une combinaison des deux.

Dans le gaming moderne, la performance se gagne souvent “par ruse”. Par exemple, un rendu interne en 1440p reconstruit en 4K peut coûter bien moins cher qu’un 4K natif. Cependant, la qualité dépend du mouvement, des particules, et des reflets. Par conséquent, des brevets sur l’analyse de vecteurs de mouvement, la détection d’artefacts, ou des filtres temporels adaptatifs sont des indices forts sur les priorités de la PS6 côté image.

CPU, GPU et répartition des tâches : vers une console plus “asynchrone”

Un autre axe fréquent concerne l’orchestration des tâches. Quand des schémas évoquent une planification fine entre calcul général, rendu, et streaming, l’idée est simple : réduire les temps morts. Ainsi, un CPU plus efficace ne signifie pas seulement plus de cœurs, mais aussi une meilleure capacité à nourrir le GPU. De plus, une exécution asynchrone mieux contrôlée améliore la stabilité des frames, ce qui est crucial pour les écrans 120 Hz.

Pour Atelier Meridian, cela se traduit par une contrainte concrète : le moteur doit découper ses jobs proprement. Sinon, le jeu “micro-saccade” malgré une moyenne élevée. Donc, si la PS6 met l’accent sur des files de commandes plus intelligentes et des priorités dynamiques, les studios devront adopter des architectures orientées tâches, plutôt que des boucles monolithiques héritées.

Comparaison pratique : PS5, PS5 Pro et projection PS6

Comparer aide à comprendre ce que les brevets cherchent à dépasser. La génération actuelle a déjà imposé SSD rapide, décompression matérielle, et ray tracing grand public. Toutefois, le coût du ray tracing complet reste élevé, donc l’industrie préfère des solutions hybrides. Ainsi, les dépôts autour du “ray reconstruction” et de la réduction de bruit sont cohérents avec une approche : plus de qualité perçue, moins de calcul brut.

| Élément | Génération actuelle (référence) | Piste cohérente via brevets (PS6) | Impact côté joueurs |

|---|---|---|---|

| Upscaling | Reconstruction variable selon les jeux | Pipeline unifié avec réglages dynamiques | Image plus nette à framerate stable |

| Scheduling | Asynchrone, mais dépendant des moteurs | Orchestration plus fine via outils et API | Moins de saccades en monde ouvert |

| Ray tracing | Hybride, coûts élevés en 60 fps | Denoising avancé et reconstructions | Reflets plus propres sans sacrifier la fluidité |

| Efficacité | Améliorée, mais limitée par le thermique | Watt-per-frame optimisé | Console plus silencieuse en charge |

Au final, ces pistes convergent : la technologie vise moins le “brute force” que la qualité stable. Ce choix est cohérent avec la réalité des moteurs et des coûts de production, donc il influence autant le design que le calendrier.

Composants PS6 : mémoire, stockage et I/O à la lumière des brevets

Les composants les plus déterminants ne sont pas toujours ceux qui font les gros titres. Certes, CPU et GPU captent l’attention, mais la mémoire et l’I/O dictent la “respiration” d’un jeu. Ainsi, des brevets sur la compression, la hiérarchisation des données, ou le préchargement intelligent pointent vers une console pensée pour le streaming massif. Cette logique est centrale pour les mondes ouverts, car la densité d’assets explose : géométrie, matériaux, animation, audio spatialisé.

Sur la génération actuelle, le SSD rapide a déjà changé la donne. Cependant, il reste des angles morts : fragmentation des ressources, latence lors des changements rapides de caméra, et surcharge CPU liée à la préparation des données. Donc, des dépôts qui optimisent la décompression, ou qui déplacent certaines étapes vers des blocs dédiés, sont des signaux concrets. Par ailleurs, la réduction des copies mémoire internes peut améliorer la stabilité, surtout quand le GPU et le CPU se disputent la bande passante.

Mémoire unifiée : plus de capacité ou meilleure gestion ?

Une question revient toujours : faut-il plus de RAM ou une meilleure utilisation ? En pratique, les studios prennent tout ce qu’on leur donne, car la taille des textures et des caches augmente. Pourtant, la capacité seule ne suffit pas si les accès sont mal planifiés. Ainsi, une innovation plausible est une gestion plus intelligente des “pools” mémoire, avec des priorités selon la distance, la vitesse du joueur, ou l’état du gameplay.

Chez Atelier Meridian, un test interne est parlant. Quand le personnage traverse une ville en véhicule, la caméra change vite, et le streaming doit suivre. Sans stratégie, des textures se chargent en retard, donc le joueur voit du “pop-in”. À l’inverse, un I/O plus prédictif, couplé à un cache mieux calibré, réduit ces défauts. Ce type d’amélioration se prête bien à des brevets, car il combine algorithmes, heuristiques et implémentation système.

Stockage, décompression et latence : un trio indissociable

Un SSD plus rapide ne sert pas à grand-chose si la chaîne de décompression est lente. Donc, des dépôts autour de la décompression parallèle, de la priorisation par type d’asset, ou de la reconstitution à la volée, sont cohérents. De plus, un travail sur la latence I/O aide aussi les fonctionnalités système, comme la reprise instantanée, l’enregistrement, ou le streaming vidéo.

Pour rendre ces enjeux concrets, voici des choix d’optimisation typiques que les studios devront intégrer, surtout si la PS6 pousse le streaming agressif :

- Segmenter les assets en “chunks” plus petits pour charger au bon moment.

- Prioriser l’audio et les shaders critiques avant les détails cosmétiques.

- Pré-calculer des niveaux de détail et des variantes compressées.

- Mesurer la latence réelle sur kit de dev, puis ajuster les budgets.

- Limiter les copies mémoire inutiles via des formats adaptés.

Cette approche n’est pas glamour, mais elle définit la qualité perçue. Et justement, c’est souvent là que la prochaine génération gagne des points, même sans “révolution” visible sur une capture d’écran.

Ces analyses de l’architecture SSD et des chaînes de décompression aident à comprendre pourquoi les brevets I/O ont un poids direct sur les composants et, indirectement, sur la date de sortie.

Technologie PS6 : refroidissement, consommation et fiabilité comme leviers d’innovation

La performance durable est devenue une discipline à part entière. Une console de jeu peut afficher un pic impressionnant, puis réduire sa fréquence si la température grimpe. Ainsi, les brevets sur la dissipation thermique, les matériaux, ou la gestion de ventilateurs ne sont pas secondaires. Au contraire, ils conditionnent le bruit, la longévité, et la stabilité des performances en session longue, ce qui compte vraiment pour le gaming.

Ensuite, l’efficacité énergétique devient un argument produit, même si le marketing en parle peu. Le coût de l’électricité et la sensibilité au bruit changent les attentes. Donc, une PS6 optimisée “watt par image” peut offrir une expérience plus premium, même sans chiffres extravagants. Par ailleurs, cela permet parfois un design plus compact, ou une marge thermique qui protège la machine l’été.

Brevets de refroidissement : au-delà du ventilateur

Les dépôts peuvent couvrir des chambres à vapeur, des caloducs optimisés, des ailettes repensées, ou une circulation d’air plus directe. Cependant, l’enjeu ne se limite pas au radiateur. Il touche aussi la répartition des sources de chaleur : VRM, mémoire, stockage. Ainsi, une conception qui “déplace” certains composants pour éviter les points chauds peut améliorer le silence, tout en simplifiant l’entretien.

Dans un scénario réaliste, Sony peut chercher à éviter les critiques de bruit en pleine charge. Par conséquent, une stratégie consiste à lisser les variations de régime, plutôt que de répondre agressivement à chaque pic. Cette gestion plus douce peut aussi s’appuyer sur des modèles prédictifs, ce qui se brevète facilement, car l’algorithme devient différenciant.

Fiabilité et maintenance : des détails qui pèsent sur l’expérience

La fiabilité ne se résume pas au taux de panne. Elle inclut la tenue dans le temps des pads thermiques, l’accumulation de poussière, et la stabilité des connecteurs. Ainsi, des brevets sur des chemins d’air “anti-dépôt”, des filtres, ou des assemblages simplifiés peuvent viser une meilleure durabilité. D’ailleurs, un design qui facilite le nettoyage réduit aussi les retours SAV, ce qui a un impact financier direct.

Pour Atelier Meridian, le sujet est moins théorique qu’il n’y paraît. Si la console maintient un framerate stable sans monter en température, le studio peut cibler des scènes plus denses, donc un spectacle plus riche. À l’inverse, si la plateforme “throttle”, les équipes doivent prévoir des garde-fous, ce qui coûte du temps de production. En somme, le refroidissement devient un facteur créatif autant qu’un sujet d’ingénierie.

Les démonstrations sur chambres à vapeur et solutions thermiques permettent de relier la technologie matérielle à des bénéfices mesurables : silence, stabilité, et marge de performance.

Gaming PS6 : compatibilité, services et stratégie produit déduite des brevets

Une plateforme ne se résume pas à ses transistors. Elle vit dans un écosystème : rétrocompatibilité, services, gestion des comptes, cloud, et outils pour développeurs. Ainsi, certains brevets peuvent viser des méthodes de compatibilité avancée, comme l’adaptation dynamique de timings, ou des couches d’abstraction pour exécuter des jeux d’anciennes générations avec moins de friction. Dans les faits, la rétrocompatibilité est devenue une attente standard, car elle sécurise la bibliothèque au moment de la transition.

Ensuite, les services influencent aussi la conception des composants. Par exemple, si la capture, l’édition et le partage deviennent plus lourds, il faut des encodeurs efficaces. De même, si le streaming de jeu progresse, la console doit gérer réseau, latence, et encodage sans plomber le gameplay local. Donc, des brevets autour de la priorisation réseau, de la réduction de jitter, ou de la synchronisation audio/vidéo sont des indices utiles pour comprendre la direction.

Rétrocompatibilité : valeur utilisateur et coût technique

Assurer la compatibilité n’est pas gratuit. Cela peut exiger des modes spéciaux du CPU/GPU, des timings mémoire particuliers, ou des profils d’alimentation. Cependant, l’intérêt est énorme : un joueur qui conserve ses jeux migre plus vite. Ainsi, si Sony protège des mécanismes d’exécution “hybrides”, cela suggère une volonté de rendre la transition douce, ce qui peut influencer la date de sortie en réduisant le besoin de line-up gigantesque.

Pour illustrer, Atelier Meridian prévoit une version PS5 et une version PS6. Si la nouvelle console exécute proprement la version PS5 avec une amélioration automatique (résolution, stabilité), le studio peut concentrer ses efforts sur un patch “enhanced” plutôt que sur un portage complet. Cette logique, déjà vue dans l’industrie, devient plus crédible quand des brevets décrivent des systèmes d’optimisation automatique.

Outils développeurs et “features” système : l’arme invisible

Les studios regardent autant les outils que la puissance. Ainsi, des dépôts sur le profiling en temps réel, la télémétrie, ou la gestion des ressources peuvent signaler une plateforme plus “observable”. Or, plus un jeu est complexe, plus l’observabilité est vitale. Par conséquent, une console qui fournit des métriques propres réduit le temps de debug, donc accélère les sorties.

Enfin, une stratégie produit se devine parfois dans la manière dont les brevets se répartissent. S’ils couvrent le multimédia, le cloud et la latence, l’objectif peut être une console polyvalente. S’ils se concentrent sur la mémoire, l’I/O et le rendu, la priorité est clairement le jeu local haut de gamme. Dans les deux cas, l’innovation sert un même but : rendre l’expérience plus fluide, plus stable, et plus simple à exploiter pour les studios.

On en dit quoi ? Les brevets ne donnent pas une fiche technique, pourtant ils révèlent une intention : une PS6 optimisée pour la stabilité, le streaming d’assets et la reconstruction d’image, plutôt que pour la surenchère brute. De plus, cette orientation colle aux contraintes thermiques et aux coûts des composants. Enfin, si Sony aligne outils et compatibilité, la date de sortie pourrait surtout dépendre du moment où l’écosystème logiciel est prêt à encaisser le saut.

Un brevet Sony confirme-t-il les composants finaux de la PS6 ?

Non. Un brevet protège une idée ou une méthode, pas un produit final. En revanche, la répétition de dépôts sur un même thème (I/O, upscaling, refroidissement) indique des priorités techniques plausibles pour la PS6 et sa stratégie hardware.

Pourquoi la date de sortie dépend-elle autant de la gravure et de l’efficacité énergétique ?

Parce que le coût, le rendement de production et le thermique déterminent le prix public et la disponibilité. Même avec une bonne architecture, une console de jeu ne peut pas sortir en volume si les composants clés restent chers ou difficiles à produire.

Les brevets sur l’upscaling signifient-ils du 8K en gaming sur PS6 ?

Ils pointent surtout vers une meilleure qualité perçue à performance constante. L’objectif le plus réaliste est un 4K plus stable, avec reconstruction avancée et moins d’artefacts. Le 8K resterait un cas d’usage limité, car il exige un budget de rendu très élevé.

Quels indices de brevets sont les plus utiles pour anticiper une innovation concrète ?

Les plus parlants décrivent une chaîne complète et exploitable : méthode + orchestration + intégration système. Par exemple, décompression/streaming d’assets, planification asynchrone CPU/GPU, ou gestion thermique prédictive. Ces sujets impactent directement le gaming et l’expérience utilisateur.