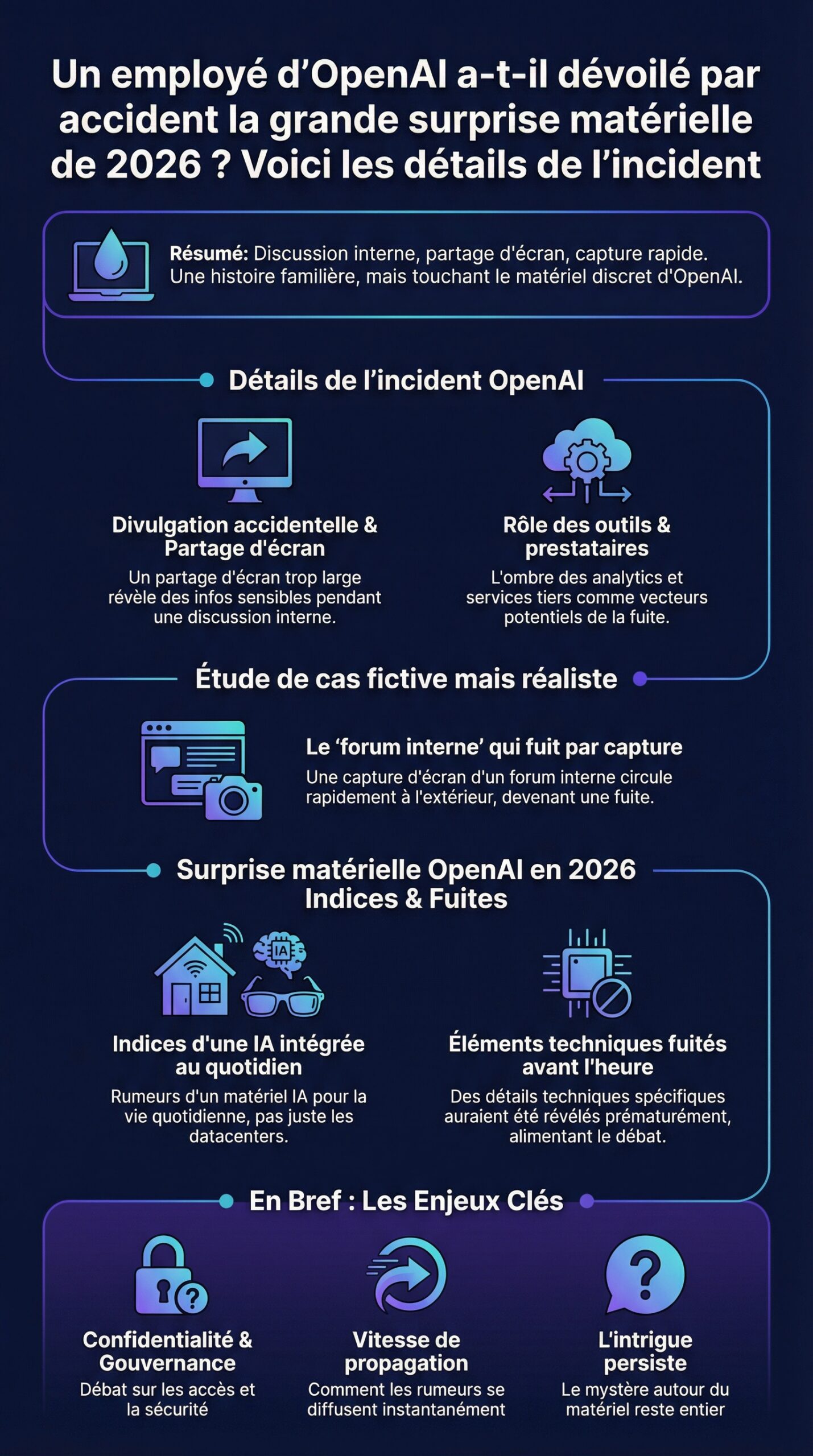

Une discussion interne, un partage d’écran trop généreux, puis une capture qui circule en quelques minutes : l’histoire ressemble à un scénario déjà vu dans la tech. Pourtant, l’incident attribué à un employé OpenAI intrigue davantage, car il touche un territoire où l’entreprise reste habituellement très discrète : le matériel. Depuis plusieurs mois, l’écosystème bruisse d’indices sur une surprise matérielle liée à l’IA, pensée pour s’intégrer au quotidien et non seulement aux datacenters. Or, cette fois, des éléments techniques auraient fuité avant l’heure, déclenchant un débat sur la confidentialité, la gouvernance des accès et la vitesse de propagation des rumeurs.

Dans les cercles hardware, la curiosité se mélange vite à l’analyse : un schéma d’architecture suffit à alimenter des comparaisons, une référence de composant évoque une chaîne d’approvisionnement, et un nom de code peut révéler une stratégie. C’est précisément ce qui rend la supposée divulgation accidentelle si sensible. Entre fuite d’information et interprétations hâtives, l’affaire met aussi en lumière les contraintes modernes : outils d’analytics, prestataires tiers, logs, forums internes et politiques de rétention. Au-delà du bruit, il reste des faits observables, des signaux cohérents, et des conséquences concrètes pour la technologie et l’innovation.

En Bref

- Un employé OpenAI aurait déclenché une divulgation accidentelle via un support de travail partagé, donnant naissance à une possible révélation sur une surprise matérielle.

- L’incident relance les questions de confidentialité : droits d’accès, prestataires, outils d’analytics et propagation sur les réseaux.

- Les indices évoquent un appareil orienté IA “au bord”, optimisé pour l’inférence locale et la réduction de latence.

- Les comparaisons se font déjà avec les puces NPU des PC Copilot+, les SoC mobiles, et les accélérateurs compacts type “AI box”.

- La gestion de crise dépend autant de la technique (audit, journaux, rotation de clés) que du facteur humain (formation, procédures, contrôle des partages).

Détails de l’incident OpenAI : comment une divulgation accidentelle peut devenir une fuite d’information

Le scénario le plus crédible, côté opérationnel, repose sur un enchaînement banal. D’abord, un document de travail est préparé pour une réunion. Ensuite, un lien est partagé avec de mauvais droits. Enfin, une capture d’écran sort de l’espace prévu. Ce type de divulgation accidentelle ne requiert ni piratage sophistiqué ni “taupe”, seulement une friction de process.

Dans les équipes produit, les supports circulent vite : briefs, jalons, budgets thermiques, contraintes de batterie, maquettes, et feuilles de route. Or, un détail suffit à déclencher une révélation. Par exemple, une référence à un “module radio” laisse penser à un appareil autonome. À l’inverse, une note “USB4/Thunderbolt” pointe plutôt vers un accessoire PC. Ainsi, l’incident devient une histoire publique, même si l’information initiale reste partielle.

Le rôle des outils et des prestataires : l’ombre des analytics et des services tiers

La plupart des entreprises tech s’appuient sur des outils externes : mesure d’usage, support client, statistiques de pages, ou instrumentation applicative. Par conséquent, la surface d’exposition grandit, même avec de bonnes intentions. Des cas connus ont déjà impliqué des prestataires d’analyse Web, capables de voir des segments de données ou des événements de navigation. D’ailleurs, des révélations passées dans le secteur ont montré qu’un intrus peut parfois exfiltrer un jeu de données via un tiers, plutôt que via la cible principale.

Cette mécanique explique pourquoi une “petite” erreur peut devenir une fuite d’information. Si un lien de document atterrit sur une page suivie par un outil d’analytics, des métadonnées peuvent être enregistrées. Ensuite, si un accès illégitime survient chez le prestataire, des fragments ressortent. Le point clé, toutefois, tient à la corrélation : l’agrégation de signaux, plus que la pièce unique.

Étude de cas fictive mais réaliste : le “forum interne” qui fuit par capture

Pour illustrer, prenons une entreprise comparable, avec un forum interne d’ingénierie. Un fil de discussion aborde un prototype matériel, car il faut coordonner firmware et application. Un salarié copie un extrait pour demander un avis sur un canal externe, pensant masquer les noms. Or, un nom de code reste visible. Quelques heures plus tard, la communauté associe ce nom à des offres d’emploi, puis à des fournisseurs repérés sur des manifestes d’expédition. Le puzzle se complète sans accès direct aux serveurs.

Dans ce contexte, la confidentialité ne dépend plus seulement du chiffrement, mais aussi des habitudes quotidiennes. À la fin, le vrai problème n’est pas “qui a hacké”, mais “qui a partagé”. Cette nuance façonne déjà la suite : l’angle hardware et les indices techniques.

Surprise matérielle OpenAI en 2026 : quels indices techniques auraient émergé de la révélation

Quand une rumeur vise une surprise matérielle, les analystes recherchent des marqueurs : consommation, dissipation thermique, connectique, et présence d’un NPU. Un matériel IA grand public a un défi clair : faire tourner des modèles utiles, avec une latence faible, tout en respectant la batterie et le bruit. Donc, le moindre indice sur un “budget watts” devient parlant.

Les éléments les plus cités dans ce type d’affaire sont rarement des schémas complets. Il s’agit plutôt de fragments : un diagramme bloc, une mention de “vision”, un composant mémoire, ou un plan de validation radio. Cependant, même des fragments orientent l’hypothèse. S’il apparaît une pile capteurs + micro + traitement local, l’objet vise l’assistance contextuelle. Si le document parle de “dock” et d’USB-C, l’objet ressemble à un accélérateur externe.

Hypothèse A : appareil autonome d’IA “au bord” pour réduire la latence

L’IA “edge” progresse parce que le cloud ne convient pas à tout. D’une part, la latence gêne les usages conversationnels en mobilité. D’autre part, certains contextes exigent de la confidentialité, par exemple des notes, des contacts, ou des images privées. Ainsi, une solution hybride émerge : traitement local pour l’instantané, cloud pour le lourd.

Dans cette hypothèse, le matériel intègre un NPU efficace, une mémoire suffisante pour des modèles compressés, et une stratégie de mise à jour robuste. On attend aussi un chiffrement matériel, car une fuite d’information sur des clés serait désastreuse. Enfin, une gestion thermique bien pensée devient déterminante : sans ventilation, le système doit lisser les pics.

Hypothèse B : module d’accélération pour PC et stations de travail

Une autre piste consiste en un module branché au PC, destiné aux créateurs ou aux développeurs. Ici, l’objectif serait de décharger l’inférence, tout en restant simple à installer. Par conséquent, on imaginerait un boîtier compact, une connectique rapide, et un SDK stable. Ce choix colle bien aux besoins “pro” : montage vidéo assisté, génération d’assets, indexation locale, et agents capables d’opérer sur les fichiers.

Ce format a aussi un avantage : il s’insère dans l’écosystème existant. En revanche, il impose une discipline logicielle : pilotes, compatibilité Windows/macOS/Linux, et gestion fine des modèles. Une révélation sur ce type de produit déclencherait immédiatement des comparatifs de performance par watt.

Les indices qui comptent vraiment : ce que cherchent les observateurs hardware

Pour éviter les fantasmes, les observateurs se concentrent sur des points concrets, car ils laissent peu de place à l’interprétation. Voici une liste de marqueurs souvent utilisés pour qualifier un prototype :

- Budget énergétique (pics et soutenu), car il dicte la forme et le bruit.

- Capacité mémoire et bande passante, car elles conditionnent la taille des modèles.

- Connectivité (Wi‑Fi, Bluetooth, cellulaire), car elle révèle l’autonomie d’usage.

- Chaîne de sécurité (secure boot, enclaves), car elle protège modèles et clés.

- Stratégie de mise à jour, car un appareil IA vieillit vite sans maintenance.

Ces signaux orientent la discussion vers le concret. Ensuite, l’étape logique consiste à comparer avec ce qui existe déjà sur le marché.

Les décryptages vidéo ont tendance à amplifier le bruit. Pourtant, ils aident aussi à clarifier la terminologie et à replacer les indices dans une architecture. À partir de là, le débat glisse vers la concurrence et les choix produit possibles.

Comparaisons marché : comment cette technologie se positionnerait face aux PC NPU, smartphones et AI boxes

Le marché a changé vite avec l’arrivée des PC équipés de NPU, des smartphones dopés à l’inférence locale, et des mini-serveurs domestiques. Donc, une surprise matérielle signée OpenAI serait jugée sur un critère simple : apporte-t-elle un usage nouveau, ou seulement un autre boîtier ? La réponse dépend du couple matériel-logiciel, plus que du silicium.

Sur PC, les plateformes récentes misent sur des workloads bien identifiés : transcription, effets vidéo, recherche locale, et assistants. Sur mobile, l’accent porte sur la photo, la synthèse vocale, et les résumés. Entre les deux, les “AI boxes” tentent de centraliser le calcul chez soi. Ainsi, un nouvel entrant doit choisir son terrain : mobilité, bureau, ou foyer.

Face aux PC avec NPU : l’enjeu du SDK et de la compatibilité

Un PC moderne dispose déjà d’un pipeline IA. Toutefois, la valeur perçue dépend de l’optimisation logicielle. Si un appareil externe propose des gains mesurables sur des modèles précis, l’intérêt monte. Sinon, le NPU intégré suffit. Par conséquent, le différentiel doit être net : latence, qualité, ou coût à l’usage.

Un autre point compte : la simplicité. Si l’utilisateur doit jongler entre runtimes, l’adoption chute. À l’inverse, une intégration “unifiée” peut créer un effet de plateforme. C’est pourquoi une révélation sur un SDK, même partielle, pèserait autant qu’un chiffre de TFLOPS.

Face aux smartphones : l’avantage du contexte, pas du brut

Les téléphones restent imbattables sur l’intégration capteurs + batterie. Donc, rivaliser en puissance pure n’a pas beaucoup de sens. En revanche, un appareil dédié peut gagner sur la spécialisation : microphones plus directionnels, traitement audio premium, ou respect renforcé de la confidentialité via stockage local et politiques strictes.

Un exemple concret : un consultant qui dicte des comptes rendus sensibles apprécie un traitement local, avec synchronisation chiffrée. Dans ce cas, la proposition de valeur n’est pas “plus rapide”, mais “plus sûr et plus pratique”. L’incident de divulgation renforce justement l’attention sur ce point.

Face aux AI boxes : la guerre du bruit, du coût et de la maintenance

Les boîtiers IA domestiques séduisent, car ils offrent une puissance stable. Cependant, ils impliquent mises à jour, ventilation, et facture électrique. Ainsi, un constructeur doit proposer une expérience quasi “électroménager”, pas un serveur à administrer. Si OpenAI vise ce segment, la différenciation pourrait venir d’une orchestration d’agents, avec des modèles adaptés au local.

Dans tous les cas, une comparaison honnête exige des tests. Cela mène naturellement aux méthodes de validation : ce qu’un labo devrait mesurer si l’appareil se confirme.

Les vidéos de benchmarks montrent un point important : sans protocole clair, les chiffres ne veulent rien dire. Ensuite, la discussion s’élargit vers la gestion de crise et la sécurisation, car l’actualité et le produit se répondent.

Confidentialité et sécurité : leçons techniques d’un incident et contre-mesures réalistes

Quand une fuite d’information survient, la tentation est de chercher un coupable unique. Pourtant, la sécurité est un système. Donc, la réponse efficace combine gouvernance, contrôles techniques et formation. Dans une entreprise de pointe, la faiblesse se niche souvent dans l’interface entre outils, pas dans un algorithme.

Un incident lié à une divulgation accidentelle met en avant quatre zones : permissions, traçabilité, segmentation, et hygiène de partage. Si un document interne devient public, la question n’est pas seulement “qui l’a vu”, mais “pourquoi l’accès était possible”. Ensuite, il faut réduire la répétition, car l’attention médiatique ne dure pas, tandis que les risques restent.

Mesures techniques : droits, journaux et rotation des secrets

En pratique, les entreprises durcissent d’abord les droits d’accès. Par exemple, un lien doit expirer vite. De même, le partage externe doit être bloqué par défaut. Ensuite, l’audit des journaux est essentiel : qui a ouvert, téléchargé, ou copié ? Cette traçabilité accélère les décisions, donc elle limite l’onde de choc.

La rotation des clés est un autre réflexe. Si un extrait révèle des endpoints ou des tokens, la réaction doit être immédiate. Cela concerne aussi les intégrations avec des prestataires. D’ailleurs, les politiques “least privilege” et les environnements isolés réduisent l’impact, même si l’erreur humaine persiste.

Mesures humaines : procédures simples, entraînement, et culture du doute

La prévention passe aussi par des règles faciles à suivre. Une checklist avant partage d’écran paraît basique, mais elle évite des dégâts. De même, des environnements “demo” séparés des environnements “prod” réduisent les fuites de données. Enfin, un canal de signalement sans peur aide à corriger vite, car les petites erreurs sont inévitables.

Une anecdote typique dans le hardware : un ingénieur envoie une photo de carte prototype pour illustrer un bug. Or, le cliché contient un code QR de traçabilité fournisseur. Résultat, la chaîne d’approvisionnement devient lisible. Ce cas montre une réalité : la confidentialité se joue dans les détails, pas dans les slogans. La prochaine étape consiste donc à définir comment tester et vérifier, sans alimenter le sensationnel.

Tests et vérifications : comment valider une révélation matérielle sans tomber dans la spéculation

Le public adore les annonces surprises, mais la vérification demande méthode. Ainsi, un bon réflexe consiste à distinguer trois niveaux : preuve primaire (document authentifié), preuve secondaire (indices corrélés), et bruit (captures sans contexte). Dans une affaire impliquant un employé OpenAI, la prudence est double, car les faux circulent vite.

Pour les journalistes hardware comme pour les passionnés, l’approche pragmatique repose sur des signaux mesurables. Si un produit existe, il laisse des traces : dépôts réglementaires radio, recrutements ciblés, partenariats industriels, et contraintes d’intégration logicielle. Cependant, une trace ne suffit pas. C’est la cohérence d’ensemble qui compte.

Protocole de test si l’appareil apparaît : performance, thermiques, bruit, autonomie

Un test sérieux commence par la consommation. Ensuite, il mesure la stabilité en charge, car l’inférence soutenue n’est pas un sprint. Puis, il examine le throttling, donc la façon dont l’appareil baisse la fréquence pour survivre thermiquement. Enfin, l’autonomie se mesure sur des scénarios réalistes : dictée, résumé de documents, vision, et conversations.

Pour rester comparable, un banc d’essai doit publier la version des modèles, les paramètres, et les runtimes. Sinon, les écarts viennent du logiciel. Cette rigueur aide aussi à comprendre la stratégie produit : un appareil peut être moyen en “généraliste”, mais excellent sur quelques tâches très optimisées.

Évaluer l’expérience : latence perçue et respect de la confidentialité

L’expérience utilisateur se joue souvent sur la latence perçue. Une réponse en 300 ms paraît “instantanée”, alors qu’une réponse en 2 secondes casse le flux. Donc, l’inférence locale a du sens si elle tient ce seuil sur les tâches courantes. Ensuite, il faut vérifier où passent les données : local, cloud, ou hybride.

Un point de contrôle concret consiste à couper le réseau et à observer. Que fonctionne-t-il encore ? Que se dégrade-t-il ? Cette approche révèle le vrai niveau de dépendance au cloud. Elle répond aussi à la question centrale posée par l’incident : la confidentialité est-elle un argument marketing, ou une propriété vérifiable ?

Fil conducteur : la PME “Atelier Lumen” et ses critères d’achat

Pour rendre l’analyse tangible, imaginons “Atelier Lumen”, une PME de design produit. L’équipe manipule des fichiers clients et des prototypes sous NDA. Elle cherche un assistant IA capable de classer des documents, générer des comptes rendus, et accélérer la recherche interne. Or, le cloud pur pose un problème de conformité. Ainsi, un boîtier IA local devient séduisant, à condition d’être administrable.

Atelier Lumen retiendrait des critères simples : chiffrement, comptes multi-utilisateurs, mises à jour garanties, et journaux d’accès. Ensuite, elle comparerait le coût total : achat, énergie, et temps de maintenance. Cette grille met fin aux fantasmes, car elle ramène la technologie à un usage. C’est là que toute innovation finit par être jugée.

Que signifie exactement « divulgation accidentelle » dans un contexte OpenAI ?

Il s’agit d’une exposition non intentionnelle d’informations internes (slide, lien, capture, extrait de ticket) due à une erreur de partage, de droits d’accès ou de procédure. Dans ce type d’incident, la fuite peut se propager sans intrusion directe des systèmes centraux, simplement par recopie et redistribution.

Pourquoi une surprise matérielle liée à l’IA serait-elle si sensible pour la confidentialité ?

Un appareil IA traite souvent des données personnelles (voix, images, documents). De plus, il embarque des clés, des modèles et des mécanismes de mise à jour. Si ces éléments sont exposés, les risques touchent à la fois la vie privée, la sécurité technique et l’avantage concurrentiel.

Quels indices permettent de distinguer une rumeur crédible d’une simple spéculation ?

Les indices crédibles sont cohérents et recoupables : contraintes d’énergie, connectique, exigences radio, dépôts réglementaires, profils de recrutement et dépendances logicielles. À l’inverse, une capture sans contexte ou des chiffres isolés se contredisent souvent et ne résistent pas à une lecture technique.

Comment tester un éventuel appareil IA pour vérifier ses promesses ?

Un test utile mesure la performance sur des scénarios réels, la consommation, la stabilité thermique (throttling), le bruit et l’autonomie. Il vérifie aussi la dépendance au réseau : ce qui fonctionne hors ligne, ce qui part au cloud, et comment les données sont chiffrées et journalisées.