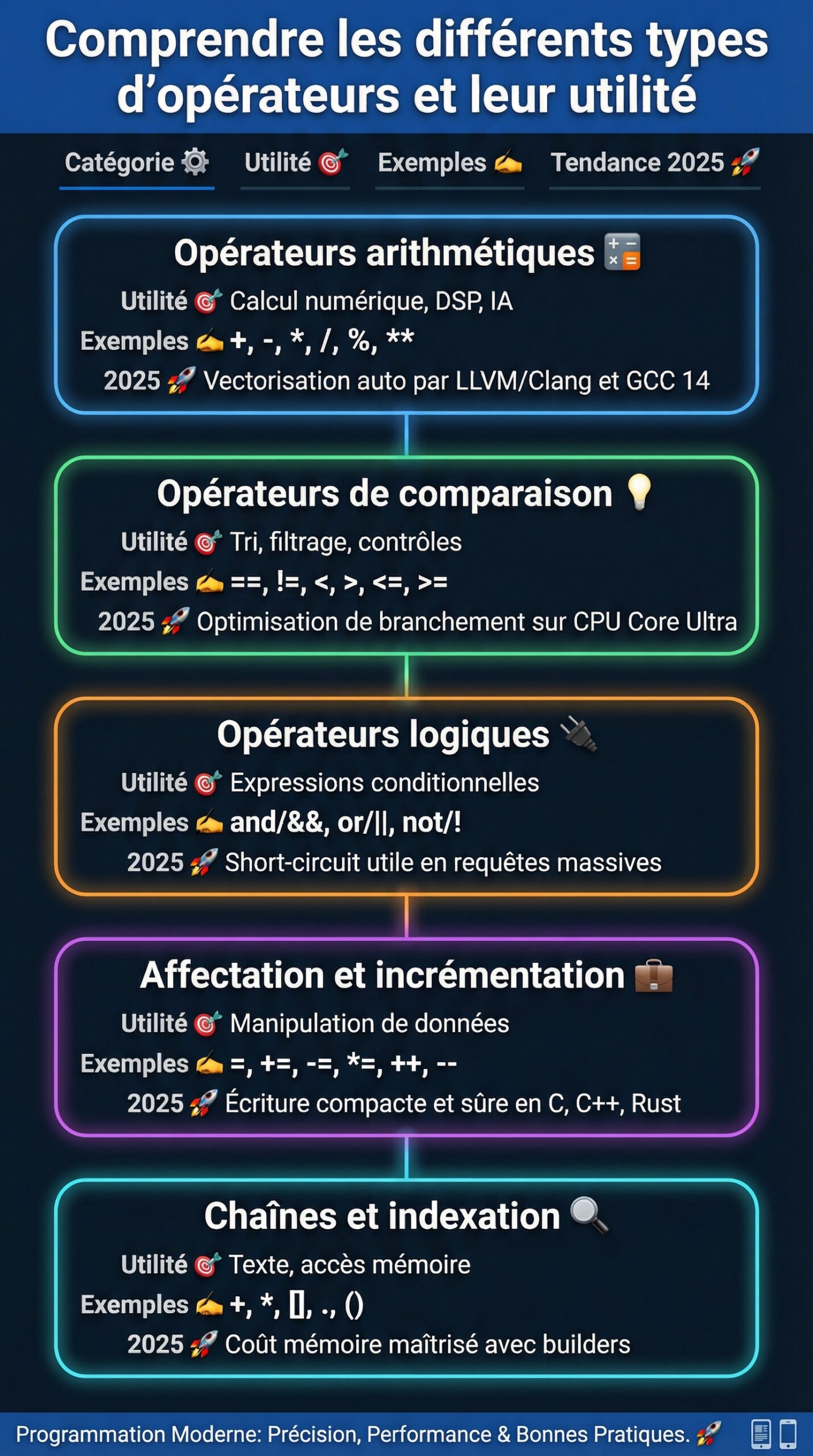

| Catégorie d’opérateurs ⚙️ | Utilité des opérateurs 🎯 | Exemples ✍️ | Point clé 2025 🚀 |

|---|---|---|---|

| Opérateurs arithmétiques | Calcul numérique, DSP, IA | +, -, *, /, %, ** | Vectorisation auto par LLVM/Clang et GCC 14 🧮 |

| Opérateurs de comparaison | Tri, filtrage, contrôles | ==, !=, <, >, <=, >= | Optimisation de branchement sur CPU Core Ultra 💡 |

| Opérateurs logiques | Expressions conditionnelles | and/&&, or/||, not/! | Short-circuit utile en requêtes massives 🔌 |

| Affectation et incrémentation | Manipulation de données | =, +=, -=, *=, ++, — | Écriture compacte et sûre en C, C++, Rust 🧰 |

| Chaînes et indexation | Texte, accès mémoire | +, *, [], ., () | Coût mémoire maîtrisé avec builders 🔍 |

Comprendre les différents types d’opérateurs et leur utilité en programmation moderne

Dans les langages actuels, les types d’opérateurs structurent la logique du code. Ils manipulent nombres, chaînes, tableaux et objets, et guident l’évaluation des expressions. Cette grammaire de base conditionne la performance, la lisibilité et la sécurité. Ainsi, bien maîtriser la syntaxe des opérateurs améliore autant la fiabilité que la vitesse d’exécution.

D’abord, les familles majeures se déploient autour de cinq ensembles. On retrouve les opérateurs arithmétiques pour les calculs, les opérateurs de comparaison pour la relation entre valeurs, les opérateurs logiques pour composer des expressions conditionnelles, les opérateurs d’affectation et d’incrémentation pour la manipulation de données, et enfin les opérateurs liés aux structures et aux chaînes. Chaque catégorie sert un but clair et possède des règles de priorité.

Ensuite, plusieurs notions gouvernent l’évaluation. Les opérandes sont les éléments sur lesquels agit un opérateur, qu’il s’agisse d’une variable ou d’un appel de fonction. Une expression combine opérateurs et opérandes, puis retourne un résultat typé. L’évaluation suit une priorité et une associativité. Par conséquent, l’usage judicieux des parenthèses reste vital, car il rend l’intention explicite.

Par ailleurs, les opérateurs se classent aussi par arité. Les opérateurs unaires prennent un seul paramètre, comme ++ ou !. Les opérateurs binaires restent les plus fréquents, par exemple + ou ==. Le cas ternaire, souvent noté condition ? a : b, agit comme un mini-contrôle de flux. Cependant, la lisibilité doit primer, surtout dans des pipelines de données.

Historiquement, les opérateurs découlent de l’algèbre et de la logique booléenne. Pourtant, leur mise en œuvre diffère selon les langages. Par exemple, Python offre ** pour la puissance, alors que C privilégie des fonctions. Et en C++, l’affectation a=b=3 se lit de droite à gauche, car l’opérateur = est associatif à droite. Ce détail évite des surprises en chaîne.

En 2025, l’utilité des opérateurs s’étend au-delà du code académique. Sur CPU et GPU récents, la forme d’une expression peut déclencher une vectorisation auto. Les bibliothèques numériques détectent des motifs comme a*b + c, puis utilisent des instructions FMA matérielles. Ainsi, une simple écriture peut gagner plusieurs cycles. Les opérateurs deviennent alors un levier de performance tangible.

Dans les systèmes embarqués, le coût d’une division entière dépasse souvent celui d’un décalage binaire. Pour des ratios de puissance, les opérateurs bit à bit accélèrent des filtres, des parsers ou des codecs. De même, sur les accélérateurs IA récents, la réduction de comparaisons inutiles allège la latence. Le code se traduit en portes logiques plus efficaces.

Enfin, écrire des expressions conditionnelles claires réduit les branches mal prédites. Les compilateurs modernes exploitent des patrons d’opérateurs pour réordonner les tests. En pratique, une bonne structure et une syntaxe des opérateurs cohérente simplifient les revues de code et limitent les bugs. Le bénéfice se mesure autant en performance qu’en maintenance.

Terminologie utile et erreurs courantes

Dans un pipeline de calcul, confondre priorité et associativité produit des écarts. Par exemple, a-b-c se lit de gauche à droite, contrairement à a=b=3 qui se lit de droite à gauche. Aussi, a=3 retourne 3 dans certains langages, ce qui autorise des enchaînements. Ce comportement surprend parfois en audit de sécurité.

Autre point, le signe – existe en deux versions. Il agit comme binaire pour a-5, mais aussi comme unaire dans a=-b. Cette dualité impacte la génération d’instructions machine. Elle influe aussi sur la détection de constantes par le compilateur. Une écriture cohérente améliore la clarté du graphe SSA.

- ✅ Astuce : ajoutez des parenthèses explicites pour figer l’ordre ⛑️

- ⚠️ Attention : évitez de mélanger ++a et a++ dans la même ligne 🧩

- 🚫 Évitez : la concaténation répétée de chaînes dans une boucle 🔄

- 💡 Bon réflexe : préférez les opérateurs composés (+=, -=) quand c’est lisible ✨

Clé finale de cette partie : un opérateur bien choisi guide le compilateur comme un indice d’intention.

Opérateurs arithmétiques et de comparaison: précision, performances et pièges

Les opérateurs arithmétiques et les opérateurs de comparaison forment la base de la plupart des algorithmes. Ils pilotent calculs et décisions. Pourtant, leur impact varie selon le type de données et l’architecture. Comprendre ces nuances améliore la robustesse des systèmes.

Pour commencer, les arithmétiques usuelles incluent +, -, *, /, et %. En Python, ** réalise la puissance. En C et C++, l’opération s’appuie sur des fonctions ou des bibliothèques. Ensuite, le type influence le résultat. Une division entière 5/2 retourne 2 en C, alors que 5/2.0 retourne 2.5. Ce détail change vite une logique métier.

Ensuite, le modulo % sert au calcul de reste. Il aide pour les index circulaires, la parité, ou des hachages simples. Par exemple, n % 2 == 0 teste un nombre pair. Toutefois, le signe en modulo négatif varie selon le langage. Valider les hypothèses évite les surprises hors spécification.

Du côté des opérateurs de comparaison, ==, !=, <, >, <=, >= évaluent des relations. Ils alimentent les expressions conditionnelles. Cependant, comparer des flottants demande une tolérance. Un test avec epsilon s’impose en calcul numérique. Sans cela, une égalité échoue pour un écart minime.

Dans des boucles de tri, la micro-optimisation de comparaisons économise des branches. Les CPU actuels disposent d’un prédicteur avancé. Mais une suite de tests incohérents coûte cher. Réordonner du plus sélectif au moins sélectif réduit le travail global. La utilité des opérateurs apparait alors dans la latence.

Exemples concrets : un moteur d’effets audio combine multiplications et additions. Les compilateurs Clang et GCC 14 détectent les schémas a*b+c et émettent des FMA. Le débit double parfois sur des blocs SIMD. D’un autre côté, en C++, activer -ffast-math modifie les lois d’associativité. Il faut mesurer l’erreur numérique avec soin.

En traitement d’images, un simple a

Bonnes pratiques et cas de contrôle

Une règle simple consiste à caster tôt vers le type cible. Ainsi, la sémantique devient claire. Puis, jalonner le code de parenthèses verrouille l’ordre. Enfin, centraliser les comparaisons critiques rend l’optimisation plus facile. Cette stratégie réduit les surprises lors des migrations de compilateur.

Exemples textuels utiles : a = 8; b = 3; a/b vaut 2 en division entière, 2.666… en flottant. Pour la comparaison, x=5; y=10; x

Dernier point pragmatique : profiler à chaque changement d’opérateurs. Des micro-benchs ciblés révèlent des effets inattendus. Les régressions se trouvent tôt. Un opérateur bien placé réduit souvent une allocation ou un branchement. La performance suit.

Conclusion locale : calculez juste, comparez sagement, mesurez systématiquement.

Opérateurs logiques et expressions conditionnelles: contrôle de flux et lisibilité

Les opérateurs logiques orchestrent les décisions. Ils assemblent des prédicats en expressions conditionnelles compactes. Le trio and/&&, or/||, not/! suffit souvent pour modéliser des règles complexes. Pourtant, la clarté doit rester prioritaire.

Commençons par le short-circuit. Avec &&, si le premier test échoue, le second n’est pas évalué. Avec ||, si le premier test réussit, la suite s’arrête. Ce comportement améliore les performances. Il protège aussi des accès nuls. Par exemple, ptr && ptr->len > 0 évite un crash.

Ensuite, la distribution logique permet de simplifier. Une expression trop dense devient illisible. Plutôt que de compacter, extraire des sous-prédicats aide. En production, ces prédicats se loggent mieux. Le diagnostic gagne en vitesse. Les post-mortem deviennent plus précis.

Sur le plan matériel, and/or/not se traduisent en portes logiques. Les CPU modernes combinent ces portes avec des comparaisons. Un bon ordonnancement limite les sauts. Par conséquent, une expression cohérente fournit un graphe de contrôle stable. Les prédictions s’améliorent.

Exemple métier : filtrer des événements réseau. On priorise la vérification d’un port ou d’un code de protocole. Puis, on teste la taille du paquet. Enfin, on applique une règle spécifique. Grâce au short-circuit, les cas majoritaires s’arrêtent tôt. La charge globale diminue.

Autre exemple, une API texte. On teste d’abord l’encodage. Ensuite, on confirme l’empreinte mémoire. Enfin, on valide la taille. Une seule clause mal placée multiplie les copies. Les opérateurs logiques réglés au mieux protègent la latence. Les clients ressentent la différence.

Côté sécurité, une négation mal comprise introduit un faux positif. Par exemple, !(a && b) ne vaut pas !a && !b. La loi de De Morgan aide à raisonner. Documenter ces transformations évite des régressions. L’équipe apprend un langage commun.

Patrons de code et tests

Un patron fiable consiste à ranger les prédicats du moins coûteux au plus coûteux. Ainsi, on limite les accès disque ou réseau. Ensuite, séparer les prédicats mutables des prédicats stables simplifie le test unitaire. Enfin, on logge les raisons d’échec avec un identifiant unique. Le support gagne du temps.

Listons des pratiques à adopter :

- 🧭 Ordre logique : du test le plus rapide au plus cher

- 🧪 Testabilité : isoler les prédicats, nommer les fonctions

- 🛡️ Robustesse : utiliser le short-circuit pour protéger les accès

- 📈 Observabilité : tracer les échecs, corréler avec des métriques

- 📚 Lisibilité : refactoriser les expressions longues

Point clé : une bonne expression logique réduit le bruit, accélère le flux, et simplifie l’audit.

Affectation, incrémentation et chaînes: écriture compacte et coût mémoire maîtrisé

Les opérateurs d’affectation et d’incrémentation guident la manipulation de données au quotidien. L’opérateur = affecte une valeur et retourne souvent le résultat. Les formes composées, telles que +=, -=, *=, /=, condensent l’intention. En algorithmique, ils rendent le code concis, donc plus lisible.

Sur l’incrémentation, ++ et — existent en version pré et post. En pré-incrément, la variable augmente puis la nouvelle valeur est fournie. En post-incrément, la variable augmente mais l’ancienne valeur est renvoyée. Cette nuance impacte la syntaxe des opérateurs en boucles. Elle modifie aussi la génération d’instructions.

Exemple textuel utile : int x=5; x++; après, x vaut 6. En Python, x+=1 remplit le même rôle. Par contre, 4++ n’a aucun sens puisqu’un littéral n’est pas une l-value. Les compilateurs modernes détectent ces erreurs tôt. Les lints renforcent le filet de sécurité.

Côté chaînes, + concatène en Python et Java. L’opérateur * répète une chaîne en Python. Par exemple, « Bonjour »*3 produit trois répétitions. Cependant, des concaténations dans une boucle allouent souvent trop. Un builder ou une jointure par séparateur réduit l’empreinte. La performance s’en ressent.

Dans les services web, ce détail se voit dès 10 000 requêtes par seconde. Chaque + déclenche une nouvelle allocation. Une structure tampon évite le coût. En C++, std::string::append et des réservations anticipées stabilisent la latence. Les pics disparaissent.

Pour les journaux applicatifs, préférer des formats structurés limite la concaténation ad hoc. Les opérateurs d’affectation composés aident à préparer des compteurs et des horodatages. Ensuite, un flush par lot amortit l’I/O. Les opérateurs bien choisis participent ainsi à la santé opérationnelle.

En C++, l’opérateur d’affectation (=) est associatif à droite. Par conséquent, a=b=3 se lit a=(b=3). Ce comportement permet de chaîner plusieurs affectations. La lisibilité reste le facteur décisif. Un code clair prime sur un compactage trop ambitieux.

Tableau repère: priorité et usage

| Priorité ⏫ | Opérateurs 🧩 | Nom 📘 | Astuce 🛠️ |

|---|---|---|---|

| 2 | a(), a[] | Appel, indexation | Très prioritaire, parenthéser le reste |

| 3 | ++a, –a, -a, ! | Pré-incrément, négations | Privilégier ++a en itération C++ |

| 5 | a*b, a/b, a%b | Multiplication, division, modulo | Mesurer les divisions entières |

| 6 | a+b, a-b | Additions, soustractions | Éviter la concat’ dans les boucles |

| 9-10 | <, <=, >, >=, ==, != | Comparaisons | Épsilon pour les flottants |

| 16 | =, +=, -=, *=, /= | Affectations | Associatif à droite en C/C++ |

Point d’attention : écrivez compact, mais jamais au détriment du débogage.

Opérateurs d’accès, indexation et appels: structures, objets et API

Au-delà du calcul, les opérateurs structurant l’accès valent de l’or. L’opérateur [] indexe des tableaux, des listes ou des vecteurs. L’opérateur . accède aux membres d’un objet. Enfin, () appelle une fonction. Ces briques décrivent l’architecture des données autant que leur usage.

En data pipelines, T[i] constitue l’accès principal. Un index hors bornes reste un risque courant. De nombreux langages offrent une variante contrôlée, par exemple at() en C++. L’exception signale une anomalie tôt. La stabilité du service y gagne.

Le point . traverse les hiérarchies d’objets. Il clarifie le modèle métier. Enfin, la signature d’un appel via () documente les dépendances. Un appel léger favorise la mise en ligne par le compilateur. Le coût s’effondre sur des fonctions courtes. Les unités deviennent plus prédictibles.

Sur les plateformes GPU et accélérateurs IA, les opérateurs d’accès guident la coalescence mémoire. Un schéma d’indexation contigu maximise la bande passante. Par conséquent, l’ordre des indices dans T[y][x] a un impact réel. Cette réflexion doit se faire tôt dans la conception.

Avec les API modernes, les opérateurs jouent un rôle dans l’ergonomie. En C++, la surcharge d’opérateurs crée des interfaces naturelles. Par exemple, operator[] pour un buffer circulaire. Cependant, l’excès nuit à la compréhension. L’équipe doit fixer des conventions claires.

En exploitation, tracer l’usage de () et [] aide à trouver des points chauds. Une simple mesure révèle un goulot d’étranglement. Réordonner les accès suffit parfois. Un gain de 20% n’est pas rare. La corrélation avec les compteurs matériels confirme l’effet.

Dans les bibliothèques numériques, les opérateurs encapsulent la logique d’alignement. Des conteneurs vectorisés exposent des accès sûrs. La documentation doit couvrir les invariants. Elle indique aussi la syntaxe des opérateurs disponible. La prise en main devient rapide.

Étude de cas: traitement d’images sur GPU

Un pipeline applique un flou gaussien puis une normalisation. L’algorithme dépend d’indexations régulières. L’équipe aligne les données sur 128 bits. L’opérateur [] parcourt alors des blocs contigus. Les lectures deviennent coalescentes. Les SM restent occupés.

Ensuite, des comparaisons pilotent un seuillage adaptatif. Les opérateurs de comparaison se transforment en masques. Les branches se réduisent. Le débit augmente. Enfin, quelques parenthèses clarifient l’ordre d’évaluation. Le portage entre compilateurs se simplifie.

Conclusion locale : les opérateurs d’accès architecturent la mémoire et la performance.

Avancés: bitwise, surcharge C++, tendances 2025 et tests ciblés

Les opérateurs bit à bit (&, |, ^, ~, <<, >>) restent cruciaux. Ils compressent, chiffrent, et manipulent des flags. Sur microcontrôleurs et firmwares, ils économisent cycles et RAM. Sur GPU, ils construisent des masques rapides. L’utilité des opérateurs dépasse donc les seuls calculs décimaux.

En C++, la surcharge d’opérateurs crée des DSL compacts. operator+ peut additionner des vecteurs mathématiques. operator[] peut offrir un accès borné. Pourtant, la lisibilité doit rester la priorité. Des règles d’équipe protègent le lecteur. La navigation devient fluide.

Par ailleurs, 2025 confirme plusieurs tendances. Les compilateurs LLVM/Clang et MSVC améliorent la vectorisation de patrons arithmétiques. Les bibliothèques standard étendent les vues et les ranges. Les opérateurs deviennent plus expressifs en pipeline. Les erreurs se réduisent grâce aux diagnostics avancés.

En Python 3.13, la gestion des chaînes et des f-strings se raffine. Les opérateurs + et * profitent d’optimisations sur CPython. Néanmoins, pour de grands volumes, join reste supérieur. Mesurer reste indispensable. Un micro-benchmark guide les choix.

Dans les moteurs IA, les comparaisons et les logiques se mappent sur des kernels spécialisés. Les frameworks identifient des sous-graphes. Ils remplacent des séquences d’opérateurs par une fusion. Le débit s’améliore. La consommation baisse. L’écriture d’expressions claires facilite ces optimisations.

Pour les tests, isoler les opérateurs critiques apporte de la précision. Un test vérifie la parité via n % 2 == 0. Un autre contrôle une comparaison flottante via une tolérance. Un troisième évalue la logique courte avec des pointeurs nuls. Le filet de sécurité devient complet.

Enfin, quelques recommandations d’atelier. Documenter la syntaxe des opérateurs acceptée par votre base. Mettre en place des lints dédiés aux expressions. Ajouter des benchmarks par scénario. Corréler avec des compteurs processeur. Le retour sur investissement se voit vite.

Ressources vidéo et rappel pratique

Pour approfondir, chercher des présentations récentes sur la vectorisation, la logique courte, et la comparaison flottante. Une démonstration claire accélère l’adoption d’un style commun. Les erreurs diminuent ensuite naturellement. Les revues gagnent en qualité.

Rappel rapide : préférer les opérateurs composés quand ils servent la lisibilité. Protéger chaque accès par un test cheap d’abord. Séparer la politique (logique) du mécanisme (accès). Résultat : un code stable, prévisible, et performant.

On en dit quoi ?

Globalement, la maîtrise des types d’opérateurs conditionne la qualité d’un système. Bien placés, ils guident le compilateur, réduisent la complexité et améliorent le débit. Mieux encore, ils clarifient l’intention. Le conseil final est simple : écrire des expressions lisibles, mesurer les effets, puis fiabiliser avec des tests ciblés. Ce trio fait la différence au quotidien.

Quels opérateurs utiliser pour vérifier rapidement la parité ?

Le test standard reste n % 2 == 0. Il est clair, immédiat, et fonctionne dans la plupart des langages de programmation.

Comment éviter les erreurs sur les comparaisons flottantes ?

Éviter l’égalité stricte. Utiliser une tolérance, par exemple fabs(a-b) < epsilon, où epsilon dépend de l’échelle des données.

Quand préférer += à a = a + b ?

Dès que la lisibilité reste intacte. L’opérateur composé rend l’intention plus nette et peut aider certaines optimisations.

Les opérateurs logiques évaluent-ils toujours toutes les parties ?

Non. && et || appliquent le short-circuit : ils arrêtent l’évaluation dès que le résultat final est connu.

Comment limiter le coût de la concaténation de chaînes ?

Éviter les additions en boucle. Pré-allouer, utiliser un builder ou une jointure avec un séparateur. Mesurer l’impact mémoire et CPU.